Что лучше одна мощная видеокарта или две средние

Преимущества и недостатки двух разных видеокарт на одном компьютере

Установка двух или более видеокарт, работающих совместно, обеспечивает улучшенную производительность видео, 3D и игр по сравнению с одной видеокартой. Как AMD, так и Nvidia предлагают решения для работы с двумя или более видеокартами, но чтобы решить, стоит ли принимать это решение, нужно рассмотреть требования и преимущества.

Требования к системе с двумя видеокартами

Преимущества

Недостатки

Большим недостатком двух видеокарт в одном компьютере является стоимость. Поскольку топовые видеокарты уже стоят 500 долларов и более, многим потребителям трудно позволить себе вторую. Хотя ATI и Nvidia предлагают более дешевые карты с поддержкой двух карт, зачастую лучше потратить одинаковое количество денег на одну карту с одинаковой или иногда лучшей производительностью, чем на две недорогие.

Другая проблема заключается в том, что не все игры выигрывают от нескольких видеокарт. Эта ситуация значительно улучшилась с тех пор, как были представлены первые настройки с двумя картами, но некоторые графические движки по-прежнему плохо справляются с двумя видеокартами. Фактически, некоторые игры могут показывать небольшое снижение производительности по сравнению с одной видеокартой. В некоторых случаях происходит поддергивание, из-за которого изображение видео выглядит прерывистым.

Современные видеокарты очень энергоемки. Наличие двух из них в системе может почти удвоить количество потраченой эллектроэнергии, необходимое для их запуска в тандеме. Например, для правильной работы одной видеокарты высокого класса может потребоваться блок питания на 500 Вт. Наличие двух таких же карт может потребовать около 850 Вт. Большинство настольных компьютеров не оснащены такими мощными блоками питания. Обратитесь к мощности вашего компьютера и требованиям, прежде чем покупать более мощное оборудование.

Преимущества производительности в среде с двумя картами зависят от других компонентов компьютерной системы. Даже с двумя графическими картами самого высокого класса процессор нижнего уровня может регулировать объем данных, которые система может предоставить графическим картам. В результате двойные видеокарты обычно рекомендуются только в высокопроизводительных системах.

Кто должен установить две видеокарты?

Для среднего потребителя запуск двух видеокарт не имеет особого смысла. Общие затраты на материнскую плату и видеокарты, не говоря уже о других основных аппаратных средствах, которые необходимы для обеспечения достаточной скорости графики, являются непомерно высокими. Однако это решение имеет смысл, если вы хотите запускать игры на нескольких дисплеях или в экстремальных разрешениях.

Начало Эры Multi-GPU видеокарт или когда две головы лучше одной

реклама

Кто ответит на вопрос «Почему?» Возможно, индийские программисты устали писать код, а возможно коронавирус этому помешал, а может производители игр не хотят заниматься дальнейшей поддержкой этой технологии? Сплошные вопросы, не так ли? Но, наш клуб с экспертами-комментаторами, я уверен, прольет свет и ответит на эти и другие вопросы.

А пока сходим в техническую библиотеку отдела Nvidia. Где-то лет 20 назад, почитаемая компания номер 1 в 3D графике приказала долго жить. И Nvidia купила ее, а заодно все её наработки и патенты. Олдфаги, догадались, что речь идет о 3DFx. 3DFx была первой компанией, которая дала миру SLi!

реклама

Одна вторая «Вуду» тянула лишь 800 на 600. Вот, тогда польза от второй видеокарты была как раз осязаема, реальна нужна. А что сейчас делать с парой RTX 3090? Хороший такой вопрос, но оставим его без ответа, на совесть владельцам RTX 3090, я думаю они появятся в обсуждении и всё нам расскажут. Я пока сижу на встройке и о RTX 3090 могу лишь мечтать, как и 99% всех, кто сюда забрел.

Итак, Nvidia купила 3DFx и получила доступ к технологии SLi. Я рассказываю по-простому, на самом деле технология построения изображения у обоих компаний в корне отличались, но для обывателя они называются одинаково и в обоих случаях обе видеокарты соединяются физически с помощью гибкого мостика, шлейфа или перепаянного куска кабеля от «флоппика». И после этого в недрах самой «зеленой» компании родился «План Б» по захвату всего рынка 3D ускорителей. Пока ATI сидела и курила нервно в сторонке, гибкие мостики окутывали умы инженеров Nvidia и маркетологов. И вот тот день настал!

реклама

А если к этому добавить смену molex коннекторов на специальные 6-pin коннекторы для видеокарт, то и на все 100%. В то время изможденные геймеры, со старыми блоками питания, бродили по компьютерным рынкам в поисках переходников molex-6pin. Тогда еще не было AliExpress и засилья китайским мастеров. Я сам ждал свой коннектор для новой видеокарты 3 дня!

реклама

Местные предприниматели его вытащили из коробки и видимо потом перепродали. В общем, проблем стало у всех как минимум на одну больше. А все из-за 3Dfx, которая протянула неожиданно ноги. Хитрые игроделы, получив допинг от известной компании сразу же заявили, что их игры будут работать быстрее в 2 раза, главное — это купить эту лицензионную игру и вторую видеокарту.

Любители помериться попугаями в тестовых бенчмарках тоже побежали покупать вторую видеокарту, ведь нужно больше золота, очков в итоговом окошке теста. В общем, как ни крути, но вторую видеокарту каждый порядочный энтузиаст был обязан купить. В то время, я был в Швеции и собственноручно видел, как сметали с прилавков магазинов новенькие 6600GT и 6800GT. Сейчас можно вспомнить аналогию очередей за Iphon’ами, хотя это скучно, ведь зачем покупать второй «Айфон»? Звонить самому себе? Я лучше побеседую с Siri.

В день анонса было разбито несколько тысяч бутылок шампанского и детских мечт. Обзорщики плакали и рыдали, ведь им посчастливилось прикоснуться к святому Граалю, квинтэссенции бытия 3D и просто хорошей видеокарте с двумя GPU на борту. Но был, как всегда, один нюанс. О котором не сочли нужным все рассказать и те пользователи, которые купили эту видеокарту, потом остались без ногтей.

Они из загрызли их до дыр. А все потому, что это волшебная видеокарта могла работать только на паре моделей материнских плат Gigabyte. Опять горе и слезы. Но главное ведь продать, а пользователи сами потом разберутся. Естественно, в мануале все было написано, но наши люди сначала делают, а потом читают. Я и сам так иногда делаю, чего скрывать.

В общем все обзорщики похвалили инициативу Gigabyte, пожали руки и разошлись, захватив с собою шампанское. А Pr-отдел гигабайта не сидел сложа руки, в недрах секретной лаборатории кипела работа над двойной 6800 GT! Черт побери, это даже круче чем сейчас одна RTX3090. И они это сделали! Так появилась Gigabyte 3D1 6800GT Dual. Это по истине царская карта взгляните сами.

За эту карту не грех и почку было в то время отдать. Внешний респектабельный вид, радиатор в позолоте, уникальный дизайн и голубой текстолит, все говорило, что к хозяину такой карты без стука лучше не подходить. Если вы проникните в его жилище чтобы хотя бы одним глазком посмотреть на этот шедевр инженерной мысли, если он вас сам не убьёт, то вас точно загрызет его собака. Поэтому нужно сначала стучаться.

Для более простых энтузиастов или младших братьев обладателей Gigabyte 3D1 6800GT Dual, компания Gigabyte выпустила младшую модель на базе двух GPU 6600 без суффикса GT. Ну а что, всё правильно, каждому брату по видеокарте. Называлась такая видеокарта Gigabyte 3D1 XL 6600 Dual.

Алло Асус? Срочно зайдите в ординаторскую, пациенту плохо! У него неизлечимая SLi-зависимость и срочно нужно видеокарто-вмешательство. Да вы не ослышались, чтобы было делать реальным пацанам с мамками не от Gigabyte? Не менять же свой топ и не изменять своему любимому бренду! А таких было много, головные боли не могли излечить даже в Pr-отделах многих компаний. Но, как всегда, нашлись спасители, кошельков и душ страждущих.

Размеры этого монстра приводили всех в шок, таких видеокарт тогда еще не видел никто! Все были в шоке, даже отец одного школьника, которого развели на эту «дуру». Мало того, что она не вмещалась в системный блок, так и старенький блок питания уходил в защиту и ни при каких обстоятельствах не выходил из неё. Пришлось покупать новый корпус и блок питания, ну а что делать, обратного пути уже не было. В комплекте к видеокарте шел специальный SLI переключатель, который позволял этой видеокарте работать, где пожелает её повелитель.

Темный кожух, приставка Extreme, на коробке сам Посейдон или Зевс, ну что еще нужно? Правильно – вторую такую! Но пока еще производители не решили эту проблему, поэтому такая видеокарта стояла в системнике в гордом одиночестве.

Сейчас сюда могут набежать многочисленные Павлики и Кириллы комментаторы, и вставить жестко свои 5 копеек, но я вам отвечу, коли SLi тогда не пробовали, не стоит и сейчас на форуме размазывать. Едем дальше. Прогресс набирал обороты, Nvidia выкатила 7000-ю серию видеокарт. Как же все обрадовались, я помню салюты возле дома. Даже один бомж спросил: «Вадим, а что за праздник?». Я говорю – Володя, это геймеры радуются. Владимир Сергеевич тогда не понял, кто такие эти геймеры, он грязно выругался и полез обратно в коробку из-под холодильника. Вот так у нас встретили новую линейку видеокарт.

В качестве ядерного реактора выступал внешний блок питания видеокарты. Инженеры из ASUS пожалели бедных отцов геймеров, теперь их старые блоки питания не боялись работать в системе с такой видеокартой. Но теперь страх был у мамы. А причем тут мать? Да при том, что чадо требовало купить эту видеокарту, а в ASUS посчитали, что только 2000 геймеров смогут ее получить, так-как она вышла в серии Limited Edition. В Pr-отделе ASUS придумали новую маркетинговую стратегию, которая в последствии еще не раз всем нам аукнется.

Итак, все матери геймеров, сплотились в одну организацию противодействия секте Liminte Edition, но ничего не вышло. Демократия она такая.

Пока они ходили с транспарантами, пара мамаш подсуетилась и купила своим 20-ти летним сыночкам сразу по паре видеокарт. Зачем? А затем, что эти две видеокарты можно было объединять в SLi, хотя соединительного мостика они не имели! Вот сюрприз, так сюрприз, а ведь многие этого и не знали. Хотя за полтос данную инфу продавали бабки в одном переулке.

Когда геймеры видели такой скриншот, они прятались под стол. Ведь такого вообще быть не могло. Но теперь даже вы знаете, что это возможно! Это и есть та магия Voodoo 😉

А результаты от игры в FEAR могли и вовсе сделать не подготовленного геймера очень нервным человеком, я сам даже боюсь смотреть на эти цифры после полуночи, а ведь тогда было еще страшнее.

Кто захочет испытать страх, сможет эту табличку и другие такие найти на THG.ru А потом все проснулись и выключили телевизор. Утром следующего дня Мир был уже не таким, как раньше. В Nvidia подумали, а почему они ходят в магазин, а сливки со сметаной все время достаются соседскому коту? Ну вы поняли, речь идет о своей прибыли. Почесав за ухом и щёлкнув пальцами, на свет была произведена по истине первая реальная DUAL-GPU видеокарт NVIDIA 7900 GX2 от самой основательницы.

Это миф или реальность? Никто не мог понять, что это за такое изделие, похоже на слоеный бутерброд. Это видеокарта – ответила маленькая девочка, ложа в свою сумочку такую же вторую. Да, теперь официально такие видеокарты поддерживали QUAD-SLi.

Если бы тогда был изобретен майнинг, все манеры бы застрелились еще тогда, только от вида таких четырех видеокарт в одной системе, и я бы вам не надоедал со своим анализом стоимости цен на видеокарты RTX 2000 и 3000-й серии. Но история пошла по другому пути.

Потом поняв, что они ошиблись, R&D Nvidia выпустил упрощенную модель NVIDIA 7950 GX2, карта была гораздо короче, что не давало такой статусности новому владельцу. И если основным производителем NVIDIA 7900 GX2 была сама Nvidia, то NVIDIA 7950 GX2 клепали все подряд. И таинства чуда и причастности к волшебству уже никто не получал. Очень жаль.

А далее события развивались по накатанной. После NVIDIA 7950 GX2 была выпущена NVIDIA 9800 GX2. Ну а что делать, деньги то нужны всем. На этот раз бутерброд обрел пластиковый кожух, который мог превращаться в маленький гробик, если геймер не пылесосил этот кирпич два раза в неделю.

Видеокарта было очень горячей, но, к сожалению, после 8800 Ultra, это уже стало нормой. Папа иногда гладил ею свой галстук, а мама могла приготовить на ней горячие пирожки, чтобы дать их собой в школу.

На этом я поставлю жирную точку. Хотя запятая была бы более актуальна, ведь история не закончилась, но я подожду ваших гнилых помидор в свой адрес в комментариях или хвалебных од в свой адрес. И вы мне скажите, что пора завязывать или писать продолжение.

Две средние видеокарты вместо одной топовой

Если судить по тестам современных адаптеров с двумя топовыми GPU (Radeon HD 7990, GeForce GTX 690) либо аналогичных конфигураций на базе отдельных карточек, технологии NVIDIA SLI и AMD CrossFireX в целом преодолели период мучительного взросления. Во многих играх двухпроцессорная система демонстрирует почти двукратное преимущество над таким же одиночным GPU, а в прочих вполне можно рассчитывать на бонус в пределах 50–70%. По крайней мере именно так обстоят дела среди игр категории ААА. Менее популярные игрушки обычно ускользают от внимания IT-изданий, и насколько хорошо их оптимизируют под SLI и CrossFireX, судить не беремся. Кроме того, в целом оптимистичную картину портят неудачи в отдельных играх, где либо производительность все-таки плохо масштабируется, либо разработчики питают пристрастие к одной из конкурирующих технологий, игнорируя другую.

В целом видеокарты с двумя GPU уже доказали право на существование на самом верху модельных рядов NVIDIA и AMD. Между тем разъемы SLI и CrossFireX теперь устанавливают даже на слабенькие по меркам геймеров адаптеры вроде Radeon HD 7770 и GeForce GTX 650 Ti BOOST. И каждый раз, когда в руки попадает очередная дешёвая видеокарта с поддержкой SLI или CrossFireX, возникает желание проверить — а как себя ведет пара таких малышек? С одной стороны, интерес чисто академический. Процессоры в геймерских видеокартах младшего эшелона по числу функциональных блоков представляют собой приблизительно половинки от топовых GPU. Вот вам еще один способ протестировать эффективность технологий, распараллеливающих вычислительную нагрузку между двумя GPU, — попытаться получить из двух половинок производительность, близкую к 100% результата топового процессора.

⇡#А оно нам надо?

Но попробуем найти в таком эксперименте и долю практической пользы. В теории тандем слабых видеокарт может стать более выгодной покупкой, чем один топовый адаптер. Старшими моделями AMD ныне являются бессменный Radeon HD 7970 и его разогнанный собрат HD 7970 GHz Edition. Среди продукции NVIDIA аналогичной парочкой можно считать GeForce GTX 680 и GTX 770. Ну а на роль их приблизительных половинок подходят Radeon HD 7790 и HD 7850 (для AMD), GTX 650 Ti BOOST и GTX 660 (для NVIDIA).

Сопоставим розничные цены этих моделей. Radeon HD 7790 со стандартным объемом памяти 1 Гбайт в московских интернет-магазинах можно купить за сумму от 4 100 рублей, HD 7850 2 Гбайт — за 4 800 рублей. В то же время Radeon HD 7970 продается по цене от 9 800 рублей, что лишь на 200 рублей дороже, чем пара HD 7850. Но вот HD 7970 GHz Edition уже трудно найти менее чем за 14 000 рублей.

Таким образом, CrossFireX на двух недорогих карточках AMD кажется сомнительной затеей хотя бы потому, что Radeon HD 7850, хоть и является половинкой HD 7970 по числу активных вычислительных блоков в GPU, существенно уступает последнему по тактовой частоте ядра и памяти. HD 7790 крутит процессор на частоте 1 ГГц, что отчасти компенсирует его более скромную конфигурацию по сравнению с HD 7850, но слабым местом HD 7790 является 128-битная шина памяти, а главное — её объем в 1 Гбайт, что обязательно скажется на производительности в тяжелых графических режимах (а именно для них мы и собираем такой тандем).

С точки зрения чистого эксперимента, не обремененного финансовыми соображениями, по конфигурации вычислительных блоков и частоты GPU совокупная мощь пары младших адаптеров AMD, способных работать в режиме CrossFireX (Radeon HD 7770 в расчет не берем, сборка из двух таких — это было бы совсем нелепо), немного не достает до флагманской отметки. Не будем забывать это обстоятельство, обсуждая результаты бенчмарков. Впрочем, в пользу пары HD 7850 играет 256-битная шина памяти — то, что NVIDIA не может предложить в этом ценовом сегменте.

| Модель | Radeon HD 7790 | Radeon HD 7850 | HD 7970 | HD 7970 GHz Edition |

|---|---|---|---|---|

| Основные компоненты | ||||

| GPU | Bonaire | Pitcairn Pro | Tahiti XT | Tahiti XT |

| Число транзисторов, млн | 2080 | 2800 | 4313 | 4313 |

| Техпроцесс, нм | 28 | 28 | 28 | 28 |

| Тактовая частота GPU, МГц: Base Clock / Boost Clock | 1000/НД | 860/НД | 925/НД | 1000/1050 |

| Потоковые процессоры | 896 | 1024 | 2048 | 2048 |

| Текстурные блоки | 56 | 64 | 128 | 128 |

| ROP | 16 | 32 | 32 | 32 |

| Видеопамять: тип, объем, Мбайт | GDDR5, 1024 | GDDR5, 2048 | GDDR5, 3072 | GDDR5, 3072 |

| Ширина шины памяти, бит | 128 | 256 | 384 | 384 |

| Тактовая частота памяти: реальная (эффективная), МГц | 1500 (6000) | 1200 (4800) | 1375 (5500) | 1500 (6000) |

| Интерфейс | PCI-Express 3.0 x16 | |||

| Вывод изображения | ||||

| Интерфейсы | 1 х DL DVI-I, 1 x DL DVI-D, 1 x HDMI 1.4a, 1 x DisplayPort 1.2 | 1 х DL DVI-I, 1 x HDMI 1.4a, 2 x Mini DisplayPort 1.2 | ||

| Макс. разрешение | VGA: 2048×1536, DVI: 2560×1600, HDMI: 4096х2160, DP: 4096х2160 | |||

| Типичная потребляемая мощность, Вт | 85 | 130 | 250 | 250+ |

| Средняя розничная цена, руб. | 4 100 | 4 800 | 9 800 | 14 000 |

Расклад цен среди видеокарт NVIDIA более благоприятен для сборки тандема из двух SKU небольшой производительности по сравнению с единственным мощным адаптером. GeForce GTX 650 Ti BOOST можно купить по цене начиная с 5 200 рублей, GeForce GTX 660 — за 5 800 рублей. Обе — с двумя гигабайтами набортной памяти. В то же время цены на GeForce GTX 680 и новоприбывший GTX 770, который является фактически обновленной версией GTX 680, начинаются с 13 000 рублей. По спецификациям GTX 650 Ti BOOST — самый младший графический ускоритель в ассортименте NVIDIA, поддерживающий SLI, — соответствует половинке GTX 680 (GTX 770) и даже располагает большим числом ROP, только работает на более низких частотах. GTX 660, при равной с GTX 650 Ti BOOST частоте, более плотно укомплектован ядрами CUDA и текстурными блоками. Обе модели обременяет относительно узкая 192-битная шина памяти.

| Модель | GeForce GTX 650 Ti BOOST | GeForce GTX 660 | GTX 680 | GTX 770 |

|---|---|---|---|---|

| Основные компоненты | ||||

| GPU | GK106 | GK106 | GK104 | GK104 |

| Число транзисторов, млн | 2 540 | 2 540 | 3 540 | 3 540 |

| Техпроцесс, нм | 28 | 28 | 28 | 28 |

| Тактовая частота GPU, МГц: Base Clock / Boost Clock | 980/1033 | 980/1033 | 1006/1058 | 1046/1085 |

| Потоковые процессоры | 768 | 960 | 1536 | 1536 |

| Текстурные блоки | 64 | 80 | 128 | 128 |

| ROP | 24 | 24 | 32 | 32 |

| Видеопамять: тип, объем, Мбайт | GDDR5, 1024/2048 | GDDR5, 2048 | GDDR5, 2048 | GDDR5, 2048 |

| Ширина шины памяти, бит | 1502 (6008) | 1502 (6008) | 1502 (6008) | 1753 (7010) |

| Тактовая частота памяти: реальная (эффективная), МГц | 192 | 192 | 256 | 256 |

| Интерфейс | PCI-Express 3.0 x16 | |||

| Вывод изображения | ||||

| Интерфейсы | 1 х DL DVI-I, 1 x DL DVI-D, 1 x HDMI 1.4a, 1 x DisplayPort 1.2 | |||

| Макс. разрешение | — | — | — | — |

| Типичная потребляемая мощность, Вт | 140 | 140 | 195 | 230 |

| Средняя розничная цена, руб. | 5 200 | 5 800 | 13 000 | 13 000 |

⇡#Обманчивые гигабайты

Ну а поскольку именно для таких игр и таких настроек мы и готовы прибегнуть к столь странному решению, как две относительно бюджетные карты в конфигурации SLI/CrossFireX, то видеоадаптеры с объемом RAM меньше 2 Гбайт нам подходят плохо. В этом плане немного больше повезло продуктам NVIDIA, поскольку даже GeForce GTX 650 Ti BOOST, согласно официальным спецификациям, поставляется в разновидности с 2 Гбайт памяти, не говоря уж о GTX 660. Кроме того, даже GTX 680 имеет не больше памяти (только для GTX 770 допустимы версии с 4 Гбайт GDDR 5).

Radeon HD 7790 задуман как адаптер исключительно с 1 Гбайт памяти, хотя партнеры AMD и производят модели с удвоенным кадровым буфером по собственной инициативе. Версия HD 7850 с 1 Гбайт памяти в связи с появлением HD 7790, напротив, официально прекратила существование. И главное, флагман-то, Radeon HD 7970 GHz Edition, комплектуется 3 Гбайт памяти — в полтора раза больше, чем у «середнячков» от AMD.

А вообще — прекратим гадать. Честное слово, производительность сборки двух геймерских видеокарт средней категории в SLI или CrossFireX трудно предсказать на основании голой теории. Нужно тестировать, и мы готовы к любым неожиданностям. Но прежде чем перейти к практической работе, обсудим еще один аспект нашего экзотического проекта — энергопотребление. Если исходить из типичной мощности адаптеров AMD, тандем HD 7850 не должен потреблять намного больше энергии, чем единственный Radeon HD 7970: 2х130 против 250 Вт соответственно. Сборка HD 7790 еще более экономична: это дважды по 85 Вт.

Сопоставимые по производительности карты NVIDIA более прожорливы. GeForce GTX 650 Ti BOOST и GTX 660 обладают одинаковым TDP — 140 Вт. В паре такие адаптеры намного превосходят GeForce GTX 680 (195 Вт) и даже GTX 770 (230 Вт).

⇡#Участники тестирования

Наша задача — собрать четыре двухпроцессорные конфигурации: на базе GeForce GTX 650 Ti BOOST и GeForce GTX 660, с одной стороны, и на Radeon HD 7790 и HD 7850 — с другой, а затем сравнить их производительность с производительностью мощных адаптеров на одном GPU.

А эти модели были выбраны в качестве конкурентов:

⇡#Участники тестирования, подробно

Большинство из карт в многопроцессорных сборках предоставлены для тестирования партнерами NVIDIA, и отличаются от адаптеров референсного дизайна по тактовым частотам. Для чистоты исследования их пришлось привести к референсным спецификациям. Впрочем, проявляя уважение к труду производителей, ниже кратко перечислим достоинства каждого из участников тестирования.

ASUS GeForce GTX 650 Ti BOOST DirectCU II OC (GTX650TIB-DC2OC-2GD5)

ASUS прислала нам немного разогнанную версию GeForce GTX 650 Ti BOOST 2 Гбайт с базовой частотой ядра, увеличенной на 40 МГц по сравнению с референсной спецификацией. На плату установлена хорошо знакомая система охлаждения DirectCU II, которая включает тепловые трубки, напрямую контактирующие с кристаллом GPU. Отсюда и название DirectCU. Вот только, в отличие от более дорогих моделей, в кулере GTX 650 Ti BOOST теплотрубок всего две штуки, а не три.

Gainward GeForce GTX 650 Ti BOOST 2GB Golden Sample (426018336-2876)

Gainward также производит разогнанную версию GeForce GTX 650 Ti BOOST с тем отличием от реализации ASUS, что базовая частота GPU увеличена лишь на 26 МГц, зато есть прибавка в 100 МГц к результирующей частоте видеопамяти. Кулер видеокарты также принадлежит к открытому типу и содержит две медные теплотрубки.

MSI GeForce GTX 660 (N660 TF 2GD5/OC)

GeForce GTX 660 в исполнении MSI оснащен солидной системой охлаждения Twin Frozr III уже с тремя тепловыми трубками. Базовую тактовую частоту GPU производитель увеличил на 53 МГц относительно референсного значения, не коснувшись частоты видеопамяти.

ZOTAC GeForce GTX 660 (ZT-60901-10M)

Эта видеокарта уже засветилась на 3DNews в изначальном тестировании GeForce GTX 660. Имеется небольшой разгон графического процессора: с базовой частоты 980 до 993 МГц. Система охлаждения представляет собой конструкцию открытого типа с двумя тепловыми трубками и медной пластиной в основании.

AMD Radeon HD 7850

Это на сто процентов референсный видеоадаптер, предоставленный самой компанией AMD. Соответственно, частоты ядра и памяти с точностью до мегагерца соответствуют эталонным. В отличие от всех остальных участников тестирования, референсный Radeon HD 7850 оснащен турбинным кулером. Радиатор имеет медную подошву и пронизан тремя тепловыми трубками.

ASUS Radeon HD 7790 DirectCU II OC (HD7790-DC2OC-1GD5)

Оверклокерская версия Radeon HD 7790 от ASUS разогнана на 75 МГц по частоте процессора и на 400 МГц — по видеопамяти. В целом GPU производства AMD допускают больший заводской разгон по сравнению с аналогами от NVIDIA. Система охлаждения карты аналогична таковой у вышеописанного ASUS GeForce GTX 650 Ti BOOST DirectCU II OC. Это упрощенный вариант кулера DirectCU II с двумя тепловыми трубками, прижатыми к кристаллу GPU.

GIGABYTE Radeon HD 7790 (GV-R779OC-1GD)

Эта карточка по конфигурации похожа на Radeon HD 7990 от ASUS: GPU работает на такой же частоте 1075 МГц, а вот частота памяти оставлена на уровне стандартных 6000 МГц. Кулер представляет собой простейшую конструкцию, образованную цельным алюминиевым радиатором и большой вертушкой. Ни теплотрубками, ни дополнительной металлической подошвой радиатора адаптер GIGABYTE похвастаться не может.

⇡#Методика тестирования

| Конфигурация тестового стенда | |

|---|---|

| CPU | Intel Core i7-3960X @ 4,6 ГГц (100×46) |

| Материнская плата | ASUS P9X79 Pro |

| Оперативная память | DDR3 Kingston HyperX 4×2 Гбайт @ 1600 МГц, 9-9-9 |

| ПЗУ | Intel SSD 520 240 Гбайт |

| Блок питания | IKONIK Vulcan, 1200 Вт |

| Охлаждение CPU | Thermalright Silver Arrow |

| Корпус | CoolerMaster Test Bench V1.0 |

| Операционная система | Windows 7 Ultimate X64 Service Pack 1 |

| ПО для карт AMD | AMD Catalyst 13.5 Beta2 + Catalyst Application Profiles 13.4 CAP1 Beta |

| ПО для карт NVIDIA | 320.14 (320.18 для GeForce GTX 780) |

| Настройки AMD Catalyst Control Center | |

|---|---|

| Antialiasing | Use application settings |

| Anisotropic Filtering | Use application settings |

| Tesselation | Use application settings |

| Catalyst A.I., Texture Filtering Quality | Quality, Enable Surface Format Optimization |

| Mipmap Detail Level | Quality |

| Wait for V-Sync | Off, unless application specifies |

| Anti-Aliasing Mode | Multi-sample AA |

| Direct3D Settings, Enable Geomery Instancing | On |

| Triple buffernig | Off |

| Настройки NVIDIA Control Panel | |

| Ambient Occlusion | Off |

| Anisotropic Filtering | Application-controlled |

| Antialiasing — Gamma correction | On |

| Antialiasing — Mode | Application-controlled |

| Antialiasing — Settings | Application-controlled |

| Antialiasing — Transparency | Off |

| CUDA — GPUs | All |

| Maximum pre-rendered frames | 3 |

| Multi-display/mixed-GPU acceleration | Multiple display performance mode |

| Power management mode | Adaptive |

| Texture filtering — Anisitropic sample optimization | Off |

| Texture filtering — Negative LOD bias | Allow |

| Texture filtering — Quality | Quality |

| Texture filtering — Trilinear optimization | On |

| Threaded optimization | Auto |

| Triple buffering | Off |

| Vertical sync | Use the 3D application settings |

| Набор бенчмарков | ||||

|---|---|---|---|---|

| Программа | API | Настройки | Режим тестирования | Разрешение |

| 3DMark 2011 | DirectX 11 | Профиль Extreme | — | — |

| 3DMark | DirectX 11 | Тест Fire Strike (не Extreme) | — | — |

| Unigine Heaven 2 | DirectX 11 | DirectX 11, макс. качество, тесселяция в режиме Extreme | AF 16x, MSAA 4x | 1920х1080 / 2560х1440 |

| Crysis Warhead + Framebuffer Crysis Warhead Benchmarking Tool | DirectX 10 | DirectX 10, макс. качество. Демо Frost Flythrough | AF 16x, MSAA 4x | 1920х1080 / 2560х1440 |

| Metro 2033 + Metro 2033 Benchmark | DirectX 11 | DirectX 11, макс. настройки, DOF, тесселяция, NVIDIA PhysX выкл. | AF 16x, MSAA 4x | 1920х1080 / 2560х1440 |

| Crysis 2 + Adrenaline Crysis 2 Benchmark Tool | DirectX 11 | DirectX 11, макс. качество, текстуры высокого разрешения. Миссия A Walk in the Park | AF 16x, Post MSAA + Edge AA | 1920х1080 / 2560х1440 |

| Far Cry 3 + FRAPS | DirectX 11 | DirectX 11, макс. качество, HDAO. Начало миссии Secure the Outpost | AF, MSAA 4x | 1920х1080 / 2560х1440 |

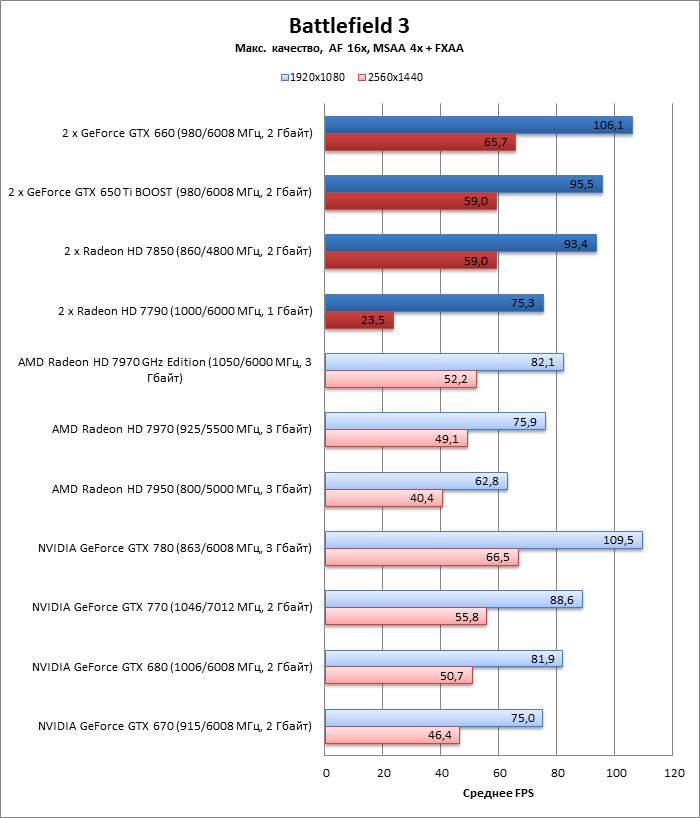

| Battlefield 3 + FRAPS | DirectX 11 | Макс. качество. Начало миссии Going Hunting | AF 16x, MSAA 4x + FXAA | 1920х1080 / 2560х1440 |

| Crysis 3 + FRAPS | DirectX 11 | Макс. качество. Начало миссии Post Human | AF 16x, MSAA 4x | 1920х1080 / 2560х1440 |

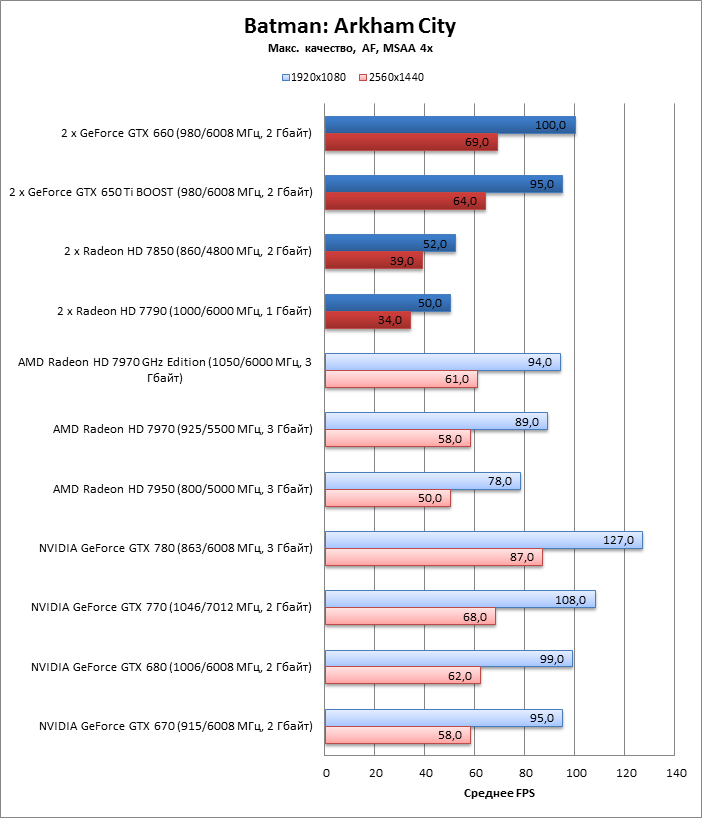

| Batman: Arkham City. Встроенный бенчмарк | DirectX 11 | Макс. качество | AF, MSAA 4x | 1920х1080 / 2560х1440 |

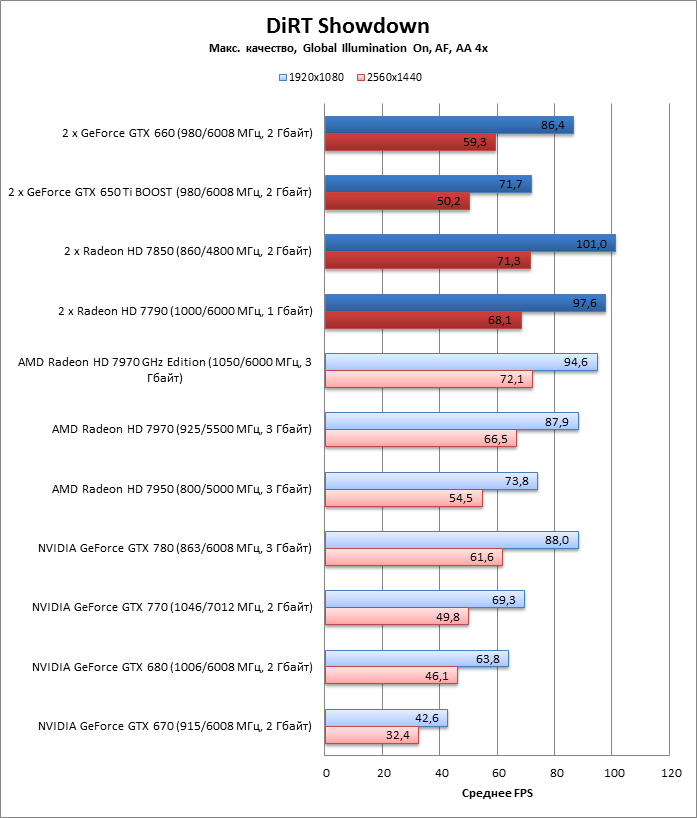

| DiRT Showdown. Встроенный бенчмарк | DirectX 11 | Макс. качество, Global Illumination вкл. Трасса Shibuya, 8 машин | AF, AA 4х | 1920х1080 / 2560х1440 |

⇡#Производительность, синтетические тесты

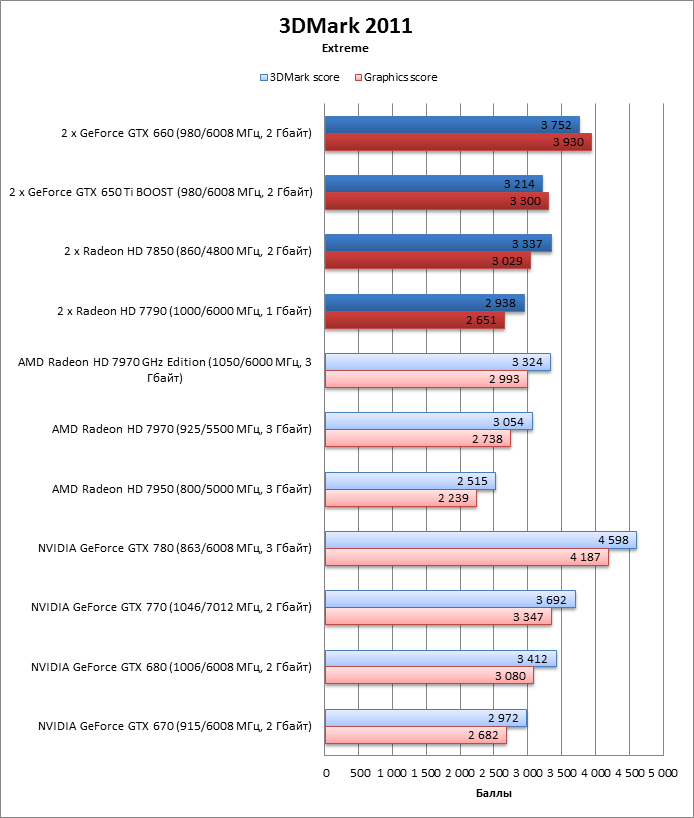

3DMark 2011 (DirectX 11)

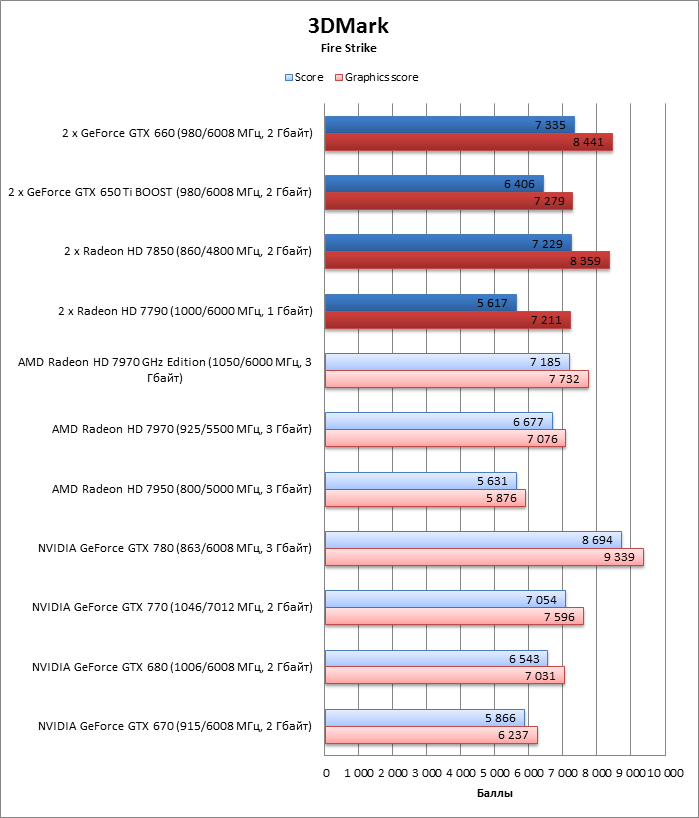

3DMark (DirectX 11)

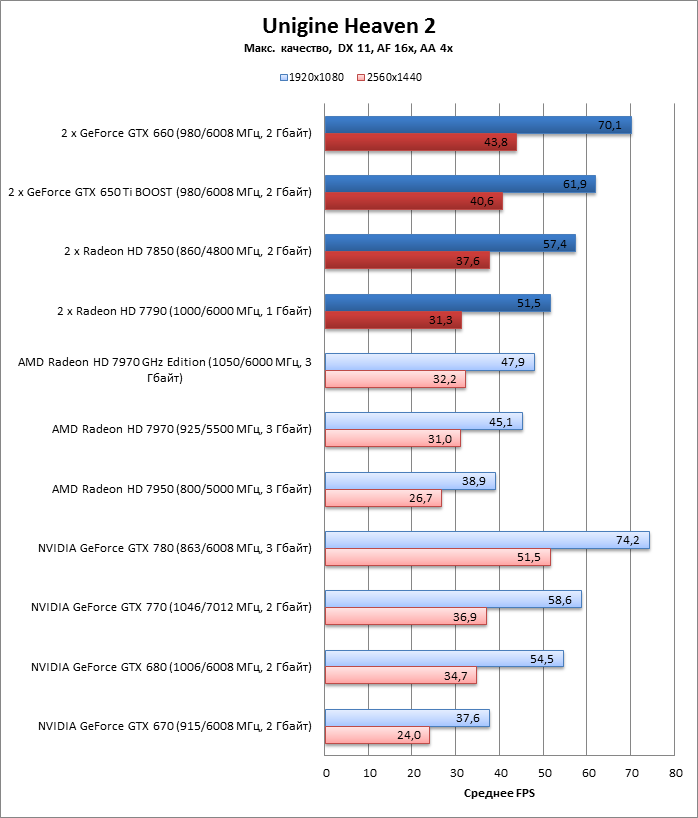

Unigine Heaven 2 (DirectX 11)

⇡#Производительность, игровые тесты

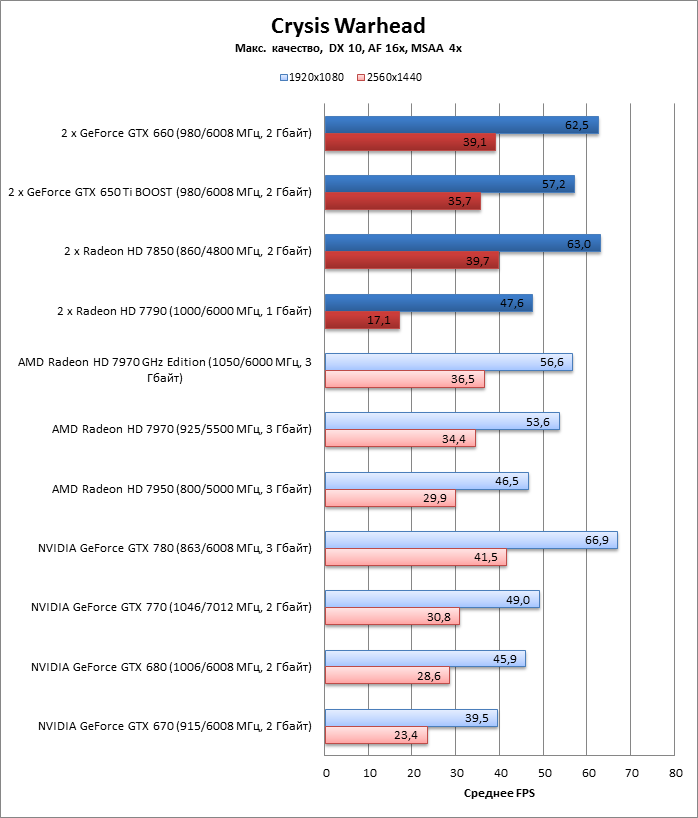

Crysis Warhead (DirectX 10)

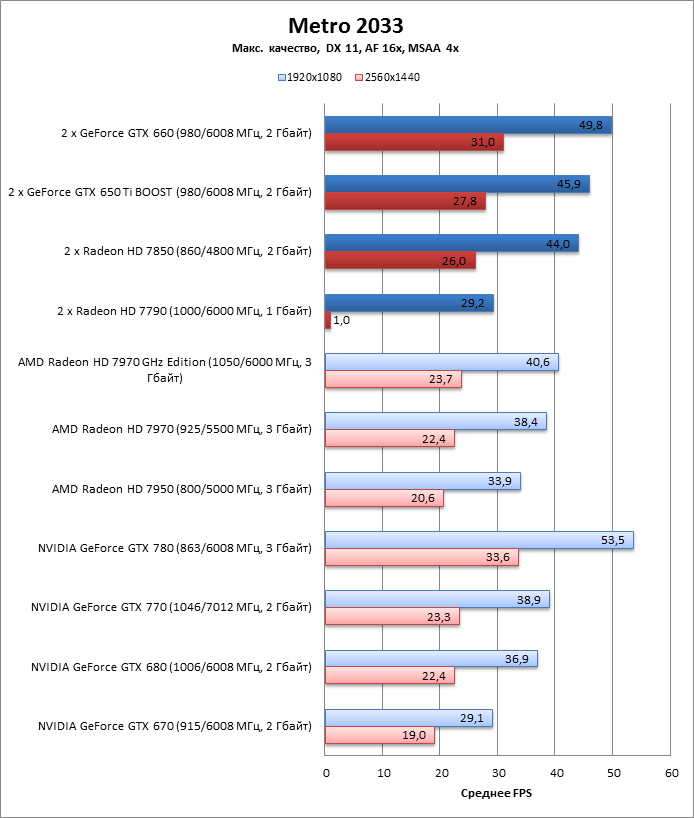

Metro 2033 (DirectX 11)

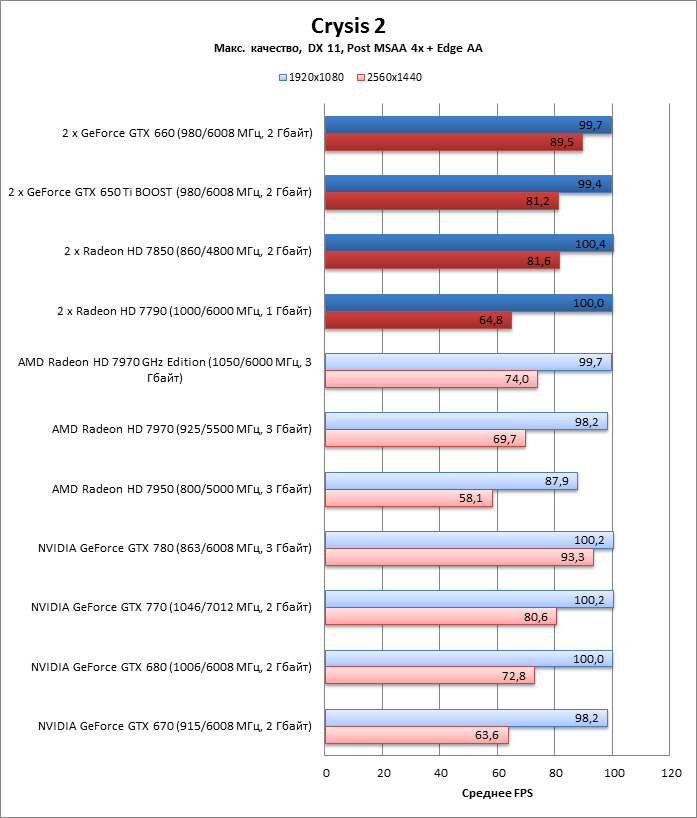

Crysis 2 (DirectX 11)

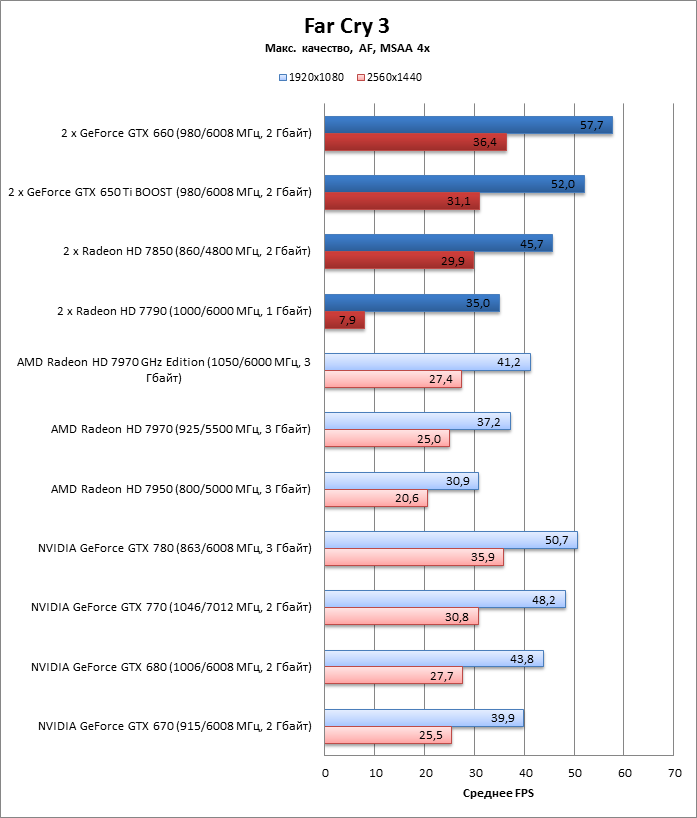

Far Cry 3 (DirectX 11)

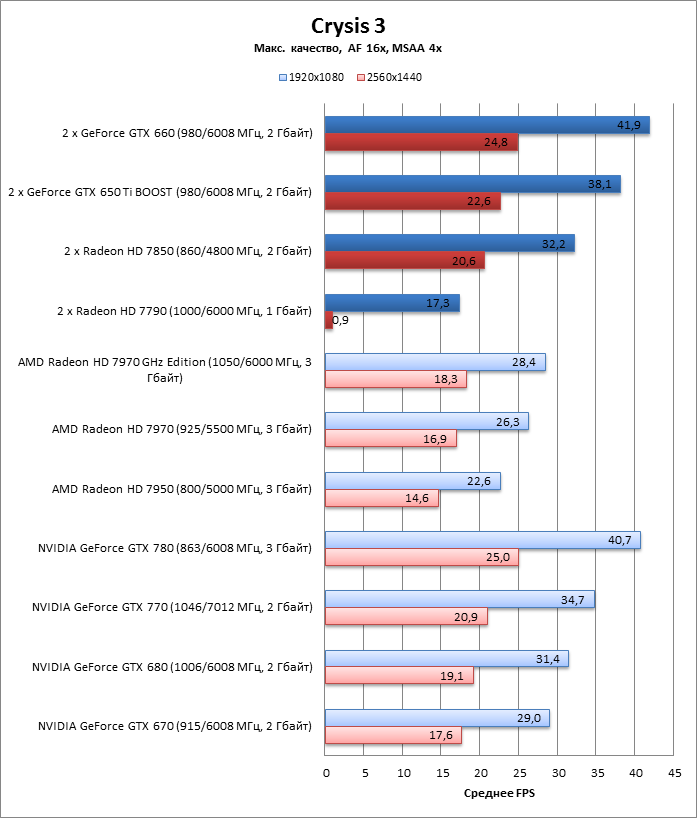

Crysis 3 (DirectX 11)

Battlefield 3 (DirectX 11)

Batman: Arkham City (DirectX 11)

DiRT Showdown (DirectX 11)

⇡#Энергопотребление

⇡#Выводы

Практические замеры производительности систем с двумя видеокартами среднего класса в режиме SLI или CrossFireX нас нешуточно удивили. Честно говоря, изначально тестирование задумывалось исключительно как курьезный эксперимент, лишенный какого-либо практического смысла. А выяснилось, что средства распараллеливания нагрузки на несколько GPU при 3D-рендеринге уже настолько вылизаны, что две видеокарты из ценовой категории для прижимистых геймеров запросто опережают по производительности один мощный флагманский (или недавно бывший таковым) видеоадаптер.

Комбинация пары Radeon HD 7790, казалось, уж точно была обречена на неудачу. Ну что могут противопоставить флагманским адаптерам два GPU Bonaire, в которых совокупное количество потоковых процессоров и текстурных модулей меньше, чем у HD 7970 с чипом Tahiti XT, да еще и со скромной шиной памяти разрядностью 128 бит? Оказывается, в двух HD 7790 достаточно пороху, чтобы отбросить HD 7950 и на равных биться c HD 7970. Но только при одном важном условии, что игре достаточно скромного кадрового буфера объемом 1 Гбайт (напомним, в CrossFireX, как и в SLI, объемы памяти двух видеокарт не складываются). Ибо если его недостаточно, то всё преимущество от второго GPU сводится на нет необходимостью гонять данные из системной памяти по шине PCI-Express, пусть даже версии 3.0

Не менее впечатляют результаты «двухголовых» конфигураций на платформе NVIDIA. Сборка двух GeForce GTX 650 Ti BOOST почти никогда не уступает бывшему флагману NVIDIA — GTX 680 — и нередко достигает уровня GeForce GTX 770. Впрочем, GTX 650 Ti BOOST и находится в более выгодном положении, чем его ближайший соперник из стана AMD — Radeon HD 7790: по количеству ядер CUDA и текстурных блоков это ровно половина чипа GK104, лежащего в основе GTX 680 и GTX 770, шина памяти — 192 бит, а объем — 2 Гбайт. Опять-таки можно сэкономить небольшую сумму, купив два GTX 650 Ti BOOST (примерно 10 500 руб.) вместо единственного GTX 680 или тем паче GTX 770.

Два GeForce GTX 660 в режиме SLI выглядели наиболее жизнеспособной из всех четырех тестовых комбинаций, ибо в совокупности два ядра GK106 с полностью функциональными вычислительными блоками по сравнению с GTX 680 имеют неплохой запас теоретической производительности. Но коль скоро даже более слабые связки составили серьезную конкуренцию одиночным видеокартам высшей категории, то неудивительно, что тандем GTX 660 стабильно опережает GeForce GTX 770 и несколько раз поравнялся с GeForce GTX 780. Увы, сменив мощный адаптер на два GTX 660, придется поступиться энергетической эффективностью, ибо две такие видеокарты потребляют больше. А стало быть, сильнее греются и наверняка сильнее шумят.

С одной стороны, за столь впечатляющие результаты надо поблагодарить программистов, которые точат и точат без устали драйверы GPU и игровые движки под SLI и CrossFireX. С другой — фактором успеха «двухголовых» систем могла стать чисто аппаратная особенность, связанная с шинами памяти. Коль скоро два GPU в тандеме работают с копиями одних и тех же данных, их можно уподобить одному процессору с количеством вычислительных блоков, примерно соответствующим оному у более крупных чипов этого же производителя. Но если GPU Tahiti имеет 384-битную шину памяти, то два GPU Pitcairn уже набирают в совокупности 512 бит. Или возьмем GK104 от NVIDIA. Он имеет 256-битную шину, а два GK106 вместе дают 384 бит. Впрочем, автор статьи не берется утверждать, что такое представление на самом деле корректно с точки зрения архитектуры SLI или CrossFireX.