Proxmox как пробросить pci устройство в виртуальную машину

Проброс видеокарты в виртуальную машину

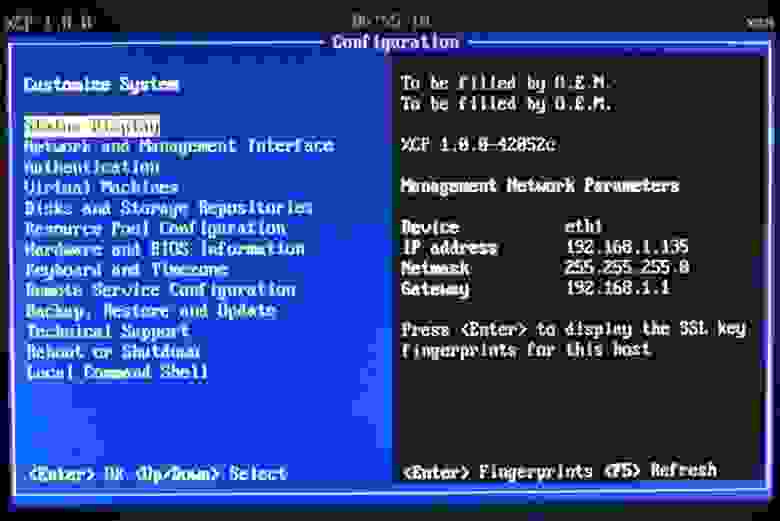

На некоторое время поставил в тупик вопрос: как этой системой рулить? В смысле, должна же быть какая-нибудь консоль управления, желательно под винды? Поковырявшись полдня с условно-штатным OpenXenManager я пришел к мысли, что то ли лыжи не едут, то ли эта кроссплатформенная тулза на винде не живет. Один или два раза она сконнектилась с сервером, но померла где-то в процессе работы, остальные разы глухо висла при коннекте, сливая неудежимый поток исключений в консоль Питона.

К счастью, более широкий взгляд в окружающий интернет открыл мне, что Citrix XenCenter прекрасно может рулить opensource-ным Xen-ом, а сам вполне бесплатен. Правда, при коннекте кричит, что через N дней у вашего сервера истечет Evaluation period, но знающие люди пишут, что это он просто не в курсе насчет opensource редакции сервера, а на самом деле все будет работать.

XenCenter позволяет создавать-включать-гасить виртуалки, а проброс устройств надо настраивать из sysadmin-friendly интерфейса командной строки.

Против ожиданий, проблем тут не случилось. Сделал все по мануалу, и хватило его одного. Вот народ жалуется, что по Xen-у документации мало. Так другой раз и хорошо, что мало, если этого хватает. Сколько я по vSphere прочел, и все без толку… Впрочем, не хочу говорить дурных слов про vSphere. Под ней зато так железо настроилось, что Xen пролетел прямо со свистом.

Итак, с помощью XenCenter я организовал виртуалку о двух ядрах и 4 ГБ памяти, накатил туда седьмую 64-битную винду и пошел пробрасывать.

pciback 0000:01:00.1: secondary bus reset failed for device — all functions need to be co-assigned — err: 6

pciback 0000:01:00.1: FLR functionality not supported; attempts to use secondary bus reset unsuccessful;

pciback 0000:01:00.1: FLR not performed for device

Похоже, что передача карты на горячую нам не светит. Ладно. Дадим гипервизору свой VGA адаптер, благо видеокарт мне теперь хватает. Переставляем Radeon 3450 во второй слот, в первый ставим валяющийся рядом 3470. К каждой карте прицепляем по монитору. Включаем хост, запускаем виртуалку. Винда просит перезагрузки после изменения конфигурации. Ребут. Логинимся…

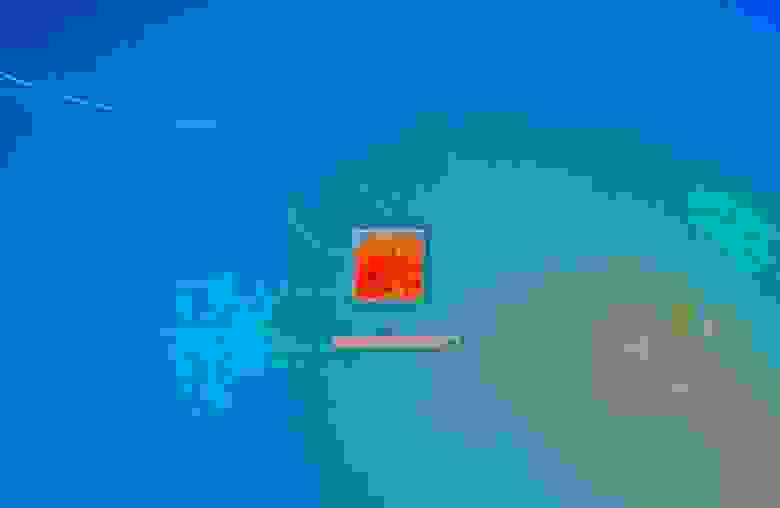

В консоли XenCenter заставка зависает, и я не сразу соображаю, что правый монитор светится синим

Оно все-таки произошло.

Итого, на Xen срослось за 3 дня (после того, как 3 месяца упражнялся на VMware).

Я залогинился. Картинка на мониторе самая обыкновенная, без особенностей. Разрешение 1920х1200 держит. Не тупит (хотя тестов не гонял). Видео с YouTube проигрывается нормально.

На этой радостной ноте завершу свой правдивый отчет, а сам займусь пробросом клавиатуры, мыши и прочей периферии.

Update:

Пробросил клавиатуру и мышь, пишу из виртуалки под Win7. Здесь ничего, жить можно.

Индекс производительности 3.5

Я даже еще не отключил Aero и прочие визуальные эффекты, вредные нашему делу, но работает шустро.

Проброс USB сделал грубо и цинично:

xe vm-param-set other-config:pci=0/0000:02:00.0,0/0000:02:00.1,0/0000:00:1a.0,0/0000:00:1d.0 uuid=d103a91d-5c38-844f-14d5-64b3c495eb08

То есть пожертвовал виртуалке USB контроллеры. С другой стороны, Xen пока без них обойдется.

Что еще? Поставил XenCenter, Xen нормально администрится (кто бы сомневался). Внешний USB-диск, естественно, тоже нормально прицепляется. Теперь надо понять, как пробрасывать CD-ROM.

К сожалению, ничего не вышло у меня с USB Passthrough, равно как и со справедливо упомянутым в комментариях Xen VGA Passthrough (Scraelos), потому как нет под XCP файла «/etc/xen/ cfgfile». Как прописать необходимые настройки с помощью xe — я не разобрался. Если знатоки Xen помогут, буду очень признателен.

Update 06.02.2012:

dom0 на IGD пересаживаться отказался в категорической форме. Кроме того, повторил попытку пробросить primary VGA adapter — без толку. Вернулся к прежней конфигурации адаптеров.

Уперся в проблему с пробросом CD(DVD)-Writer. CD-ROM пробрасывается штатно, но только RO, а мне надо RW. По этому поводу нашел 2 рекомендации: воткнуть и пробросить отдельный SATA контроллер и использовать USB CD/DVD-Writer (благо USB пробрасывается). К сожалению, даже эти (имхо, костыльные) решения у меня на данный момент не заработали. Контроллер пробрасываться отказался. Попытка подключить штатный SATA CD/DVD привод через переходник USB-SATA ни к чему хорошему не привела. Продолжаю опыты.

Proxmox: как сделать проброс GPU Intel UHD 605 внутрь виртуалки?

Здравствуйте, господа. Имеется следующее железо:

— ASRock J5005-ITX (UEFI);

— Intel Pentium Silver J5005 (VT-x, VT-d);

— Intel UHD Graphics 605 (подключение к монитору по HDMI);

— 2 x 8 DDR4-2400 SO-DIMM.

Установил Debian 10 («Stretch»), поверх него «накатил» Proxmox 6 (дальнейшее управление осуществляется через Web-интерфейс с другого ПК, который находится в той же локальной сети).

1. В файле /etc/default/grub изменил строку:

2. Добавил в конец файла /etc/modules следующие строки:

3. В конец файла /etc/modprobe.d/pve-blacklist.conf добавил строки:

4. Создал файл /etc/modprobe.d/kvm.conf и добавил в него строку:

options kvm ignore_msrs=1

5. Создал файл /etc/modprobe.d/vfio.conf и добавил в него строку:

options vfio-pci ids=8086:3184

6. Из пакета firmware-misc-nonfree извлёк файл glk_dmc_ver1_04.bin и скопировал его в директорию /usr/share/kvm.

7. Привёл файл виртуальной машины /etc/pve/qemu-server/100.conf к следующему виду:

При запуске виртуальной машины там же появляются следующие строки:

При остановке виртуальной машины там же появляются следующие строки:

И, самое главное, при запуске виртуальной машины напрочь пропадает изображение на мониторе, который подключён через HDMI. Светодиод на мониторе начинает мигать как при отсутствии видеосигнала с ПК.

Подскажите, пожалуйста, как добиться изображения на мониторе, которое (в теории) должно выводиться от виртуальной машины? Хотелось бы, чтобы видеокарточка в виртуалке работала на максимуме своей производительности (примерно как на реальном железе).

GPU (desktop/laptop) Passthrough (Проброс видеокарты в ВМ) в ProxMox. Нюансы настроек. переезжаем в Linux

Comments 25

А есть какая-то возможность организовать всё это при следующих условиях:

— монитор лишь один (с 2 входами и возможностью переключения между ними в настройках монитора)

— видеокарта без портов (т.е. она работает чисто как 3D-ускоритель, передавая картинку на встроенную графику по PCI-E)

таким образом, сетап соответствует схеме

Чисто теоретически есть, но сразу говорю, что я не пробовал данную методику, а описанная мной все же требует или видеопорт, подключенный напрямую к ВК, или прямой вывод дискретки на дисплей ноутбука:

Есть еще один вариант, это проброс интегрированной ВК в ВМ, судя по всему работает почти на любом ЦП от Интел, начиная с 4го поколения, но конкретно под ProxMox’ом работает медленно, есть вопросы по выводу изображения на дисплей. Гуглится по gvt-d

Встройку можно и целиком пробрасывать, как и отдельную видяху. И вывод на монитор будет работать без особых проблем. Даже звук по HDMI можно передавать, если ещё и встроенный звук пробросить.

Я глубоко не копал, но пробросить встройку как отдельную ВК в ВМ у меня не получилось с наскока. Чисто теоретически в этом случае изображение пойдет, для ноутбука, не на внешний дисплей, а на дисплей ноутбука, что сделает работу комфортной. Конечно мыслится что если физически прокинуть ядра ЦП + встройку + дискретку, то получим на выходе тот же ноутбук, но в виртуалке. Но практически пока что у меня не получилось.

Возможно это будет следующая тема для моей новой статьи.

Не совсем понимаю, зачем вообще это на ноуте?

А ещё если на ноуте есть дискретное видео, то в схеме «Muxed» дискретное видео не сможет выводить картинку на экран, хотя и будет доступно в хост-системе (т.к. мультиплексор управляется встроенной видяхой, а она недоступна хосту при пробросе в виртуалку)

Лично я этой темой заморачивался т.к. у меня неттоп, который и роутер и файлопомойка и куча чего ещё чисто серверного. И я решил, до кучи, сделать из него ещё и медиацентр (Kodi, Steam, RetroArch и т.д.) причем с виндой в отдельной виртуалке с возможностью подключать физическую клаву/мыш/геймпад

Не совсем понимаю, зачем вообще это на ноуте?

Виртуализация несет как плюсы, так и минусы. Лично для меня главное это удобства резервирования и безопасности.

Лично я этой темой заморачивался т.к. у меня неттоп, который и роутер и файлопомойка и куча чего ещё чисто серверного. И я решил, до кучи, сделать из него ещё и медиацентр (Kodi, Steam, RetroArch и т.д.) причем с виндой в отдельной виртуалке с возможностью подключать физическую клаву/мыш/геймпад

на чем реализовывали? каким гайдом пользовались для настройки?

Резервирование? Так это другими способами делается (Кажется у Акрониса была тулза, позволяющая делать снэпшоты диска и откатываться на них, если потребуется. Онаже позволяла вообще не сохранять изменения на диске при перезагрузке компа)

Конфиг самой виртуалки с виндой и проброшенной встроенной видяхой

В «args» идут два параметра:

Ps: До чего же неудобный и кривой редактор текста на хабре. жуть.

Резервирование? Так это другими способами делается (Кажется у Акрониса была тулза, позволяющая делать снэпшоты диска и откатываться на них, если потребуется. Онаже позволяла вообще не сохранять изменения на диске при перезагрузке компа)

Как по мне бэкап виртуалок удобнее и проще. Не нужно перезагружаться например, для отката. Я могу разворачивать несколько копий из бэкапа на одном и том же диске и ставить их параллельно. Акронис такое не позволит без танцев с бубном.

На Хосте Линукс, если настроить сеть для ВМ без доступа в интернет, то сохранность данных на виртуалке резко повышается, а всяких вирусов под линукс сильно меньше чем под винду.

Гипервизор себя ничем не выдает внешне, с учетом того что Линукс для большинства пользователей темный лес, то даже при попадении ноутбука в чужие руки, например хозяин ушел на обед, а вагончик ПТО оказался открытым с техникой для технадзора, то вытащить оттуда инфу он не сможет. Даже если вынет диск физически.

Интересно. Нужно будет пробовать.

у вас получилось изолировать устройство? У меня на домашнем ПК не вышло, в итоге вылетает вся группа, а в ней LAN. и привет сеть и тырнет.

у вас получилось изолировать устройство?

Вроде того. Proxmox позволяет частичный проброс, даже если в группе несколько устройств.

Моя IOMMU группа со звуковухой

Не знаю, как, но SMBus, ISA, MemControl не прокинулись в виртуалку. Только звук. Остальное осталось в хосте и, вродь как, работает.

Ps: Сетевухи у меня все в отдельных группах (6 штук!)

Даже если вынет диск физически.

И VirtualBox с виндой, если очень надо.

Не знаю, как, но SMBus, ISA, MemControl не прокинулись в виртуалку. Только звук. Остальное осталось в хосте и, вродь как, работает.

для их проброса в ВМ нужно принудительно прописывать, для хоста они тоже отваливаются, после старта ВМ с проброшенной звуковой картой введите на хосте lspci

специалисту да это возможно, или good user’у, но у меня на участке народ не такой продвинутый что бы разобраться что на хосте с Линуксом крутится виртуалка и все данные в ней. Особенно если еще и Линукс затюнить под винду. Хотя на счет этого я еще не определился. За условные 10-30мин они не разберутся, мне этого достаточно. А если требуется отсутствовать дольше, то я всегда уношу с собой ноутбук в спец рюкзаке.

А GVTd-D — это именно виртуальные ускорители графики

Нет это именно проброс всей видяхи. И правильнее GVT-d, а виртуальные это GVT-g

Работать будет, но будет очень небольшой лаг, связанный с копированием памяти из дискретной GPU в встройку — именно этим и занимается Looking Glass.

4.1 Linux при настройке локального времени почему-то считает что время установленное в BIOS это время по Гринвичу (GMT+0), в соответствии с локализацией к этому времени добавляются еще свой родной часовой пояс, MSK (GMT+3) в случае автора.

Про формат времени спасибо! Буду пробовать.

4.1 Linux при настройке локального времени почему-то считает что время установленное в BIOS это время по Гринвичу (GMT+0), в соответствии с локализацией к этому времени добавляются еще свой родной часовой пояс, MSK (GMT+3) в случае автора. В то время как Windows время из BIOS считает местным, в зависимости от настроек часового пояса в системе юзера. Таким образом, если Linux стоит дуал-бутом в Windows и Linux, местное время в двух ОС принимает разницу в 3 часа. Немного неудобно.

скорее наоборот windows почему-то по умолчанию хранит время не в utc.

получается чтобы узнать какое время хранится в rtc, нам нужно где-то хранить стороннюю информацию: в каком часовом поясе мы находимся и был ли произведён переход на летнее/зимнее время.

например, в случае использования нескольких ос на одном компьютере мы получаем проблему с синхронизацией этой информации между ними.

И возникают одни вопросы, что такое сенсоры: temp1, Sensor 1, Sensor 2?

увы, датчики не унифицированы, нужно смотреть для вашей материнской платы (может быть кто-то выложил в гугле, или можно путём экспериментов с виндовым софтом или bios выяснить что где).

хотя на самом деле эта информация практически бесполезна.

Где тут температуры дискретной ВК

не подскажу, у меня как-то везде интегрированное видео.

возможно, их тут вообще нет )

посмотрите вывод консольного sensors, там понятнее какое значение к чему относится

fancontrol у меня не установился

не установился или не получилось управлять оборотами кулеров? если второе, то, как я понимаю, это нормально для ноутбуков (

хотя могу ошибаться, у сейчас на руках только один нотбук с linux, оборотами там управляет bios, всё просто работает, не было даже повода разбираться.

то же самое с настольным компьютером: fancontrol работает, но схема из bios меня полностью устраивает, поэтому fancontrol удалил, зачем мне дополнительная потенциальная точка отказа.

fancontrol от Tuxedo в Debian ставится отказывается, в то время как tuxedo-control-center встал со скрипом… видимо в данном случае совместимость софта между Ubuntu и Debian не полноценная, а может быть я чего-то не знаю/не учел

смешивать пакеты из разных дистрибутивов (и даже из разных релизов одного дистрибутива) очень не рекомендуется.

Когда по заказу пытался сделать DAW на виртуалке, посоветовался с опытным админом. Он сказал, что одного проброса мало, надо у хоста отгрызть часть ядер процессора на этапе загрузки и отдать их гостю полностью. Иначе хорошего тайминга не получить.

Но если всё железо отдавать гостю в монопольное владение, то может её загружать прямо на железе? Тогда я так и сделал. Вы не рассматривали вариант без виртуализации?

Работа в виртуальной машине имеет как свои плюсы, так и свои минусы, например виртуалку проще бэкапить и разворачивать, можно настраивать под разные задачи и прятать ее. С другой стороны ее работа требует определенного железа, обычно виртуалке не выделяется 100% ресурсов, пусть минимальные, но есть потери на виртуализацию, порядка 2-5%. Виртуализация это инструмент.

Лично для меня это способ, с одной стороны, перейти на Линкус максимально просто и безболезненно, но при этом для работы пользоваться софтом Windows, с другой стороны это дополнительная безопасность данных. У этого есть своя цена, озвученная выше, я считаю что меня она устраивает.

Согласен с вами, потеря ресурсов почти всегда минимальная. Но отзывчивость (latency) системы сильно страдает. Кстати, в вашем способе прокидывания дисков на виртуалку сильно падает скорость? Когда проверял на qemu, то хорошие результаты почти без потерь iops получил только с hostdev type=’scsi’. Но в последних версиях он считается не самым быстрым.

В этом видео есть тесты скорости дисков

В первом случае это тест скорости чтения/записи в виртуальный SATA диск, который базируется на 2.5″ SATA SSD Kingston 480Gb, второй тест это тест 3.5″ SATA HDD WD Red 4Tb проброшенного в виртуалку напрямую, но без контроллера sata1: volume=/dev/disk/by-id/ata-WDC_WD40EFRX-68WT0N6_WD-WCC4E1АС9SХ9

Просадки есть, главным образом по чтению/записи рандомных блоков. Линейная скорость почти не просела

Меня результаты полностью устраивают, потому что для казуального гейминга, работы с видеоредактором и работы в офисе более чем хватает, на глаз я не вижу разницы.

Так что последние NUC-и не советую брать, если интересует хоть какое-то использование интел графики в виртуальном окружении. Сам попал на это — лучше бы купил решение на амд. У интела обычно все лучше в плане дров для встройки под линуксом, но с последними они что-то накосячили и kvm/qemu с ними не работает нормально (вернее нужен специальный патченный видеобиос которого конечно же нет в наличии)

Плохо работает на amd платформах десктопных, требуются обновления bios, кучу шаманств с параметрами загрузчика и после этого переодические проблемы разного характера.

Также плохо работает на старых интелах, где нет поддержки в процессоре и с старыми bios

Также плохо работает на старых интелах, где нет поддержки в процессоре и с старыми bios

Ну это на ооочень старых интелах.

Плохо работает на amd платформах десктопных, требуются обновления bios, кучу шаманств с параметрами загрузчика и после этого переодические проблемы разного характера.

Но оно хотя бы работает. Т.е. если нужен Single GPU Passthrough и какой либо из новых процов, то тут только амд, т.к. повторюсь, что на 11-м поколении интела и выше пока что это не возможно (и бубен не поможет). И еще раз повторюсь что это есть в ACRN-е от интела, но продукт уж очень специфический и довольно таки глючный (хоть и очень интересный по фичам — например из коробки есть поддержка прямого вывода виртуальной GVT-g карты на hdmi и т.д.). И все бубны при настройке виртуалок и графики на амд, просто цветочки по сравнению с установкой и настройкой ACRN-а

начиная с 6-й версии ProxMox’а для случаев когда юзер для ВМ использует БИОС UEFI, а иначе ВК не пробросить в ВМ

Отлично всё работает на любом BIOS’е. Просто требуются разные шаманские обряды, чтобы оно заработало.

Вопрос для понимания, пока на стадии изучения и тестирования (могу немного путать теплое с мягким))):

В чем принципиальное отличие в виртуализации и организации массивов и ФС, кроме графической оболочки:

Proxmox от Debian + |KVM + IOMMU| + |LXC| + |RaidZ + ZFS|

Unraid от Debian + |KVM + IOMMU| + |Docker| + |Snapraid + XFS + BTRFS|

OMV от Debian + |KVM| + |Docker| + |Mdraid + ext4 + RaidZ + ZFS|

Понятно что функционал бегло по основному (для меня сейчас), хочется понять что принципиально нового, удобного, полезного в выборе данных оболочек против Linux с установленными и настроенными модулями вручную?

Кто хочет кидайте тапки, но вот начал выбирать систему (FreeBSD не рассматривал), принципы реализации, и получается что в каждом варианте ИМХО есть четко выраженные взгляды создателей оболочек, систем (называйте как угодно), и приходится подстраиваться, либо править то, что не рекомендует создатель и при обновлении модулей оболочки что-то да имеет большую вероятность «полететь». В каждой из этих систем так или иначе для тонкой настройки приходится лазить под капот, дак не проще ли сразу под капот засунуть все что требуется без шилдика?

Например я хочу использовать |KVM + IOMMU| + |Docker|+ |LXC|+ |Mdraid + Snapraid + ext4| + Оболочку для мониторинга и быстрой корректировки как у OMV, но не OMV, но оболочка дело привычки ей как раз можно пренебречь и поставить тот же Webmin или Cockpit, хотя и тот и другой как две противоположности мне не зашли, лучше вообще без оболочки и пользоваться окружением через VNC если припрет «пощелкать» по визуальному интерфейсу + добавить приблуду для мониторинга по типу Grafana.

Верно ли я понял, что чего-то принципиально революционного отличающегося от чистого Linux Debian, Ubuntu, и прочих + нужные приложения и модули, в подобных оболочках нет?

Хочется услышать мнение опытных практиков. Спасибо.

🐹 Proxmox Virtual Environment 7: Установка, настройка, тюнинг, организация резервного копирования.

Опубликовано 2021-09-09 · Обновлено 2021-09-21

Содержание:

1. Постановка задачи.

Требуется организовать простой и надёжный гипервизор для сервера среднего и малого офиса:

2. Описание программы.

2.1. О программе.

В сегодняшней статье мы опишем процесс установки Proxmox Virtual Environment (Proxmox VE) — систему управления виртуализации с открытым кодом, которая базируется на QEMU/KVM и LXC. Данное решение позволяет вам управлять виртуальными машинами, контейнерами, отказоустойчивыми кластерами, СХД и прочие — все это с помощью web-интерфейса или CLI. Чтобы было понятнее — Proxmox VE — это альтернатива c открытым программным кодом таким продуктам как VMware vSphere, Microsoft Hyper-V или Citrix XenServer.

Важное уточнение — согласно лицензии GNU AGPL v3 данное программное обеспечение является бесплатным, но, есть возможность купить подписку. Подписка дает следующие преимущества — поддержка от вендора/коммьюнити (в зависимости от выбранного плана), доступ к репозиторию и так далее.

Proxmox Virtual Environment (Proxmox VE) — система виртуализации с открытым исходным кодом, основанная на Debian GNU/Linux. Разрабатывается австрийской фирмой Proxmox Server Solutions GmbH, спонсируемой Internet Foundation Austria.

В качестве гипервизоров использует KVM и LXC. Соответственно, способна выполнять любые поддерживаемые KVM операционные системы с минимальными потерями производительности и GNU/Linux без потерь.

Управление виртуальными машинами и администрирование самого сервера производятся через web-интерфейс либо через стандартный интерфейс командной строки GNU/Linux.

Для создаваемых виртуальных машин доступно множество опций: используемый гипервизор, тип хранилища (файл образа или LVM), тип эмулируемой дисковой подсистемы (IDE, SCSI или VirtIO), тип эмулируемой сетевой карты, количество доступных процессоров и другие.

Немного о системных требованиях — в идеале, требуется железный сервер, предпочтительно многопроцессорный и 8 Гб памяти для самого Proxmox и остальное — для гостевых машин + 2 сетевых карты, работает и на 1 сетевой карте (всё зависит от трафика вашего файлообмена).

Список поддерживаемых web-интерфейс Proxmox Virtual Environment (Proxmox VE) с браузеров включает Chrome, Mozilla Firefox, Safari и IE (актуальные версии).

2.2. Ключевые возможности.

Экраны web-интерфейса Proxmox VE:

С сайта разработчиков можно загрузить готовые шаблоны (как дистрибутивы общего назначения, так и настроенные под конкретную задачу, например запуск MediaWiki, Drupal или WordPress). Также можно создавать собственные шаблоны, воспользовавшись инструментом Debian Appliance Builder.

2.3. С чего начать?

Есть два варианта установки Proxmox VE — использовать готовый образ или установка на Debian. Мы будем использовать заранее готовый образ с официального сайта!

При установке среды виртуализации меняется ядро GNU/Linux. Это может привести к потери работоспособности уже установленных сервисов. Таким образом, установку Proxmox следует выполнять на чистый сервер, а не тот, который уже используется для каких-либо задач.

Для начала установки нужно скачать образ установочного диска с официального сайта разработчиков Proxmox: https://proxmox.com.

Для тех, кому интересно почитать подробнее, есть даже Proxmox VE Wiki — это справочная библиотека от разработчиков этого гипервизора: https://proxmox.com.

3. Подготовка загрузочной флешки.

Устанавливать Proxmox VE на сервер будем с помощью загрузочной флешки, которую следует предварительно подготовить с помощью специальной бесплатной утилиты — программы Rufus.

Rufus — Простое создание загрузочных USB-дисков.

Rufus — это утилита, которая помогает форматировать и создавать загрузочные Flash/Pen/Key диски, карты памяти и так далее.

Rufus будет особенно полезен в случаях, когда:

Несмотря на небольшой размер, Rufus умеет делать все, что вам нужно!

Скачиваем последнюю версию с сайта разработчиков Rufus: https://rufus.ie/ru_RU.html.

Подключаем флешку к компьютеру, выбираем ее в Rufus и выбираем файл-образ Proxmox VE, прожигаем его на флешку в режиме DD-образ. Если этого не сделать, то на некоторых BIOS флешка не загрузится как нужно и начала установки не произойдет.

После прожига флешки, можно её использовать для установки Proxmox VE.

4. Подготовка сервера.

4.1. Включение виртуализации на сервере.

Поддержка виртуализации Intel VT или AMD-V может быть отключена на материнской плате. Для проверки заходим в БИОС — находим раздел настройки процессора (как правило, в пункте меню Advanced) — проверяем, что технология виртуализации (Intel VT, AMD-V, Virtualization Technology, VMX) включена (Enabled).

4.2. Процесс установки.

Итак, вы скачали ISO-образ по ссылке выше, запустились с загрузочной флешки и должны увидеть следующее.

Кликаем на Install в интерфейсе Proxmox VE.

Стартанет загрузка информации с флешки.

После этого появится окно с установкой и EULA. Промотайте вниз и согласитель клавишей I agree:

Затем, нам предлагают выбрать диск для установки — выбираем диск и файловую системк на нем. Далее кликаем Next:

Выбираем страну и часовой пояс и кликаем Next:

Затем придумываем сложный рутовый пароль и вводим действующий e-mail — на него в случае чего будут приходить письма с происшествиями на сервере:

Следующим шагом будет настройка сетевого подключения и FQDN-имени сервера:

Указываем настройки сети — выбираем адаптер, указываем хостнейм и так далее. Кликаем Next.

Следующим экраном будет таблица с резюме наших настроек.

Если всё верно, кликаем Install:

Начинается процесс установки, который занимает не более 10 минут:

Установка заканчивается, и все, что нужно сделать — это нажать Reboot, если об этом попросит установщик.

Внимание! Если после перезагрузки сразу извлечь установочную флешку из сервера, то по каким-то неясным причинам на сервере что-то пойдет не так! И прийдется вся монтировать руками и доделывать установку в ручном режиме. Чтобы этого не произошло, не вынимайте установочную флешку до тех пор, пока не войдете в web-интерфейс Proxmox VE.

После перезагрузки вы увидите адрес, по которому нужно зайти в браузере для завершения установки.

Внимание! Флешку можно забрать после установки, когда вас поприветвует CLI интерфейс. Выключите сервер, достаньте флешку и снова включите сервер.

Внимание! Обратите особое внимание на адрес по которому работает web-интерфейс Proxmox VE! Как можно не сразу заметить используется защищенный протокол HTTPS вместо HTTP. Автоматического перенаправления в системе не предусмотрено! Будьте внимательны!

В данном случае это https://ваш-IP-адрес:8006 :

Нас поприветствует окно входа:

Появляется окно логина, с возможностью выбрать язык. Вводите логин root и пароль, который вы указывали при установке.

Выскочит надпись о том, что Proxmox VE хоть и бесплатный, но подписку на его регулярные обновления неплохо бы было прикупить… Жмём ОК… Потом настроим, чтобы и рыбку съесть и на люстре покачаться….

Далее должно открыться окно управления.

И, наконец, системой можно пользоваться! К примеру, можете кликнуть на вкладку Datacenter слева и увидеть сводку информации по системе:

5. Загрузка образов ISO в web-интерфейсе.

Чтобы начать использовать Proxmox и создать первую виртуальную машину, требуется загрузить на гипервизор ISO образ гостевой операционной системы, которую мы и установим в на виртуальную машину.

Кликаем по Datacenter — и дважды по storage:

Мы можем создать отдельное хранилище для образов ISO. Для этого переходим в раздел Datacenter —> Хранилище —> Создать —> Каталог.

Переходим в раздел Содержимое и кликаем по Загрузить:

В открывшемся окне выбираем ISO-образ системы, который будем устанавливать в качестве гостевой и кликаем по Загрузить. Ждем окончания копирования файла на сервер.

6. Настройка системы хранения данных.

Хочется обратить внимание на то, что Proxmox готов к созданию новых виртуальных машин сразу после установки. Тем не менее, рекомендуем выполнить предварительные настройки, чтобы в дальнейшем системой было легко управлять. Практика показывает, что гипервизор и виртуальные машины стоит разнести по разным физическим носителям. О том, как это сделать и пойдет речь ниже.

6.1. Настроить дисковые накопители.

Следующим этапом следует настроить хранилище, которое можно будет использовать для сохранения данных виртуальных машин и резервных копий.

Внимание! Приведенный ниже пример дисковой разметки можно использовать только для тестовых целей. Для эксплуатации в реальных условиях настоятельно рекомендуется использовать программный или аппаратный RAID-массив, чтобы исключить потерю данных при выходе дисков из строя.

Как подготовить и подключить диски можно прочитать в этих инструкциях:

6.2. Добавить новое хранилище в Proxmox.

Авторизуемся в панели управления и заходим в разделы Datacenter —> Хранилище —> Добавить —> Директория.

В открывшемся окне заполняем следующие поля:

После этого нажимаем кнопку Добавить. На этом настройка завершена.

7. Создание виртуальной машины.

Базовая настройка закончена — можно начать создавать виртуальные машины!

В правой верхней части панели управления кликаем по Создать VM:

В открывшемся окне снизу сразу ставим галочку Расширенный:

Задаем имя виртуальной машине и ставим галочку Запуск при загрузке (если хотим, чтобы виртуалка запускалась автоматически с сервером PVE):

В данном примере мы задали имя FS. При желании, также можно изменить VM ID, но он проставляется автоматически и имеет правильное значение.

Выбираем загруженный нами ISO-образ, с которого будем ставить операционную систему, задаем тип гостевой операционной системы и ее версию:

В данном примере мы будем устанавливать GNU/Linux Ubuntu. Среди списка операционных систем также доступны Microsoft Windows, Solaris и прочие.

На вкладке Система можно оставить все значения по умолчанию:

В некоторых случаях, необходимо выбрать другую видеокарту (при установке систем с GUI), а также особый вариант BIOS.

Задаем размер жесткого диска:

Величны в 16 Гб HDD для Ubuntu достаточно, однако, для наших задач расчет должен быть индивидуальным для каждой создаваемой виртуальной машины.

Подробнее об используемых в Proxmox форматах накопителей:

RAW. Самый понятный и простой формат. Это файл с данными жесткого диска «байт в байт» без сжатия или оптимизации. Это очень удобный формат, поскольку его легко смонтировать стандартной командой mount в любой GNU/Linux системе. Более того это самый быстрый «тип» накопителя, так как гипервизору не нужно его никак обрабатывать.

Серьезным недостатком этого формата является то, что сколько Вы выделили места для виртуальной машины, ровно столько места на жестком диске и будет занимать файл в формате RAW (вне зависимости от реально занятого места внутри виртуальной машины).

QEMU image format (qcow2). Пожалуй, самый универсальный формат для выполнения любых задач. Его преимущество в том, что файл с данными будет содержать только реально занятое место внутри виртуальной машины. Например, если было выделено 40 Гб места, а реально было занято только 2 Гб, то все остальное место будет доступно для других виртуальных машин. Это очень актуально в условиях экономии дискового пространства.

Небольшим минусом работы с этим форматом является следующее: чтобы примонтировать такой образ в любой другой системе, потребуется вначале загрузить особый драйвер nbd, а также использовать утилиту qemu-nbd, которая позволит операционной системе обращаться к файлу как к обычному блочному устройству. После этого образ станет доступен для монтирования, разбиения на разделы, осуществления проверки файловой системы и прочих операций.

Следует помнить, что все операции ввода-вывода при использовании этого формата программно обрабатываются, что влечет за собой замедление при активной работе с дисковой подсистемой. Если стоит задача развернуть на сервере базу данных, то лучше выбрать формат RAW.

VMware image format (vmdk). Этот формат является «родным» для гипервизора VMware vSphere и был включен в Proxmox для совместимости. Он позволяет выполнить миграцию виртуальной машины VMware в инфраструктуру Proxmox.

Использование vmdk на постоянной основе не рекомендуется, данный формат самый медленный в Proxmox, поэтому он годится лишь для выполнения миграции, не более. Вероятно в обозримом будущем этот недостаток будет устранен.

Продолжим создавать виртуальную машину.

Мы можем задать количество процессоров и ядер:

В данном примере мы создаем виртуалку с 2 процессорами, каждый из который с 2 ядрами, итого, 4. Для ненагруженных систем можно оставить значение по умолчанию.

Наша Ubuntu будет работать с 2 Гб оперативной памяти.

Выбираем созданный бридж — либо для получения прямого адреса из сети, либо для NAT:

Если виртуальная машина должна подключаться к интернету напрямую, то отключите Брандмауэр. В данном примере, мы указали vmbr0 для подключения к сети напрямую.

Ставим галочку, чтобы виртуальная машина сразу запустилась после создания:

Нажимаем Готово. Ждем окончания процесса и переходим к консоли:

Мы должны увидеть загрузку с ISO-образа.

8. Настройка виртуальной машины.

После создания виртуальной машины нам может понадобиться ее изменить. Рассмотрим процесс настройки на примере изменения некоторых параметром, а также добавления диска и сетевого адаптера.

8.1. Полезные настройки.

Для начала, переходим к виртуальной машине — Параметры:

Чаще всего могут понадобиться следующие настройки:

Для изменения параметра, просто кликаем по нему дважды, меняем значение и нажимаем OK.

8.2. Добавление дискового накопителя.

Переходим в подраздел Оборудование — кликаем по Добавить и выбираем Жесткий диск:

В открывшемся окне задаем размер диска и нажимаем OK.

Для увеличения размера имеющегося диска устанавливаем на него курсов и кликаем по Изменить размер диска:

В открывшемся окне задаем объем, на который нужно увеличить дисковое пространство.

8.3. Добавление сетевого адаптера.

Переходим в подраздел Оборудование — кликаем по Добавить и выбираем Сетевое устройство:

Как при создании виртуальной машины, выбираем тип сетевого адаптера (бридж или нат) и нажимаем Добавить.

8.4. Удаление виртуальной машины.

Для удаления виртуальной машины, сначала ее отключаем — это можно сделать из операционной системы или из панели управления, нажав на стрелку вниз рядом с Выключить — Остановка:

После кликаем по Дополнительно —> Удалить:

В открывшемся окне мы должны подтвердить свои намерения удалить виртуальную машину, вписав ее идентификатор:

Если поставить галочку Purge, то виртуальная машина будет удалена полностью вместе с виртуальным диском.

Кликаем по Удалить — готово.

9. Тюнинг сервера Proxmox VE.

Внесем несколько изменений, которые сделают работу с Proxmox VE удобнее.

9.1. Отключение предупреждения об отсутствии подписки.

Каждый раз при заходе в панель управления мы будем видеть такое предупреждение:

Оно говорит нам о том, что мы используем бесплатную версию программного продукта.

Внимание! После подключения бесплатных репозиториев, данное предупреждение должно пропасть и не появляться, но это не точно!

Алгоритм борьбы с окошком такой:

Для начала — удалим платный репозиторий.

И так, в SSH открываем на редактирование репозиторий Proxmox:

Вносим в файл изменения вида:

Актуальную информацию и бесплатных репозиториях можно получить на официальной странице базы знаний Proxmox VE: https://pve.proxmox.com/wiki/Package_Repositories.

Чтобы выйти из nano, просто нажмите ^X (клавиши Ctrl + X). Затем ENTER на предложение записать файл с новой информацие поверх старого. Если файл еще не был сохранен, вам будет предложено сохранить изменения с помощью Yes/No или отменить Выход. Нажмите на клавиатуре Shift + Y и затем клавишу Enter.

При большом желании, можно удалить файл репозитория с именем pve-enterprise.list и создать новый — кому как будет удобнее.

Вот здесь лежит еще много чего интересного: http://download.proxmox.com/debian. Сейчас этим и воспользуемся.

Активируем бесплатные репозитории:

Скачиваем патчик с официального сайта:

После обновим список пакетов:

В заключение отметим, что стабильная работа репозиториев без подписки не гарантируется. Обновления, поступающие по этому каналу, с большей вероятностью будут новейшими и/или тестовыми обновлениями. Они не проверяются, чтобы убедиться, что все работает стабильно.

Таким образом, действуйте на свой страх и риск — и, опять же, если Proxmox VE помогает вашему бизнесу, сделайте одолжение людям, приобретя подписку.

9.2. Сертификаты.

Сервер Proxmox VE устанавливается с самоподписанным сертификатом. Это означает, что при подключении к панели управления мы будем видеть предупреждение от системы безопасности. Чтобы браузер принимал сертификат, он должен соответствовать следующим требованиям:

При этом, мы не должны заходить в панель управления по IP-адресу — в противном случае, независимо от сертификата получим предупреждение.

И так, сам сертификат можно купить, запросить бесплатно у Let’s Encrypt или создать с использованием локального центра сертификации, например, по данной инструкции.

Получив сертификат, открываем панель управления Proxmox VE и переходим к серверу — Система —> Сертификаты — кликаем по Загрузить пользовательский сертификат:

В открывшемся окне заполняем поля для закрытого и открытого ключей:

Нажимаем Загрузить. Система предупредит, что загрузится с новым сертификатом — необходимо закрыть вкладку в браузере и открыть консоль управления снова. Если сертификат загружен правильный, мы не увидим предупреждения.

9.3. Создание нового пользователя.

При установке Proxmox VE создается пользователь root. Рассмотрим процесс добавления еще одного через командную строку.

Подключаемся по SSH или открываем консоль из панели управления.

Создаем пользователя в системе:

Где user — имя создаваемого пользователя.

После создаем нового пользователя в Proxmox:

# pveum useradd user@pam

В данном примере мы создали пользователя user в области pam.

# pveum passwd user@pam

Задаем роль для созданного пользователя, например, административную:

Весь список ролей можно посмотреть в панели администрирования в разделе Datacenter —> Разрешения —> Роли.

9.4. Удаление LVM-local-data.

Как реструктурировать LVM Volume \root LVM раздел?

Смотрим какая ситуация на сервере вообще?

Удалим раздел /dev/pve/data :

Дадим согласие на продолжение операции удаления — y.

Добавим всё освободившееся пространство к root разделу:

Итого: root раздел увеличился!

9.5. Проксирование Proxmox VE через Nginx.

Данная инструкция позволит вам получить доступ к Proxmox VE через 443 порт.

Как настроить Nginx и получить бесплатные сертификаты Let’s Encrypt на доменное имя описано в этой инструкции: «CentOS 7: Настройка бесплатного ssl-сертификата Let’s Encrypt.»

Создадим каталог для log-файлов:

Добавим на него права:

Создадим новый конфигурационный файл для Nginx:

Ниже приведен пример конфигурации, которая работает для web-интерфейса, а также консоли noVNC:

Перезагрузим Nginx:

# systemctl restart nginx

Файлы, размещенные на веб-сервере Nginx, являются общедоступными по умолчанию. Если вы хотите защитить файлы от несанкционированного доступа, вы можете использовать базовую аутентификацию HTTP. Это простой метод аутентификации, при котором пользователям необходимо предоставить имя пользователя и пароль для доступа к файлам на вашем сервере.

9.6. Добавление физического диска в виртуальную машину Proxmox.

Чтобы «прокинуть» физический диск целиком в виртуальную машину, нужно в файл конфигурации виртуальной машины и добавить в него одну строку по аналогии с другими строками.

Открываем состав виртуальной машины:

Оно, конечно, будет работать в традиционном режиме, как обычный диск, и отображаться традиционным жестким диском в Диспетчере дисков гостевой операционной системы, но весь подвох в том, что если в Proxmox VE съедет буквенная нумерация дисков, то гостевая система потеряет конкретно этот проброшенный жесткий диск или его заменит его на совершенно другой, совершенно левый, жесткий диск, у которого появится данная буквенная нумерация путем досадного сдвига всех буквенных индексов.

Для того, чтобы не попасть в такую досадную ситуацию, гипервизору Proxmox VE требуется объяснить, что мы хотим использовать для наших целей конкретный жесткий диск с конкретным индексом в системе и никакой другой!

Посмотрим что у нас есть в системе вообще физически и найдем наше устройство:

Выключаем виртуальную машину полностью.

Используем следующий синтаксис вида:

В итоге образец команды будет выглядеть так:

Открываем состав виртуальной машины:

Теперь виртуальная машина получила в свое распоряжение целый физический диск, управляемый виртуальным контроллером на основе технологии VirtIO. Если ваша гостевая операционная система умеет пользоваться подобным виртуальным устройством, то можно смело приступать к его использованию. Если не знает, как операционная система Windows, то потребуется дополнительная установка драйверов под контроллер такого типа.

9.6.1. Установка VirtIO драйвера в гостевой Windows.

Установка VirtIO драйвера весьма простая.

Диск можно использовать на свое усмотрение.

9.7. Проброс USB устройств в Proxmox.

Очень нужная вещь, когда в виртуальную машину Proxmox VE нужно пробросить какое-то USB устройство.

Прописываем в конфигурацию ID флешек:

# qm set 101 –usb0 host=XXXX:YYYY

где 101 — ID виртуальной машины куда будем пробрасывать порт. А XXXX:YYYY — ID USB устройства.

9.8. Установка полезных утилит и программ:

9.8.1. Установка Midnight Commander.

Один из файловых менеджеров с текстовым интерфейсом типа Norton Commander для UNIX-подобных операционных систем.

9.8.2. Установка Parted.

Parted — известный инструмент командной строки, который позволяет вам легко управлять разделами жесткого диска. Это может помочь вам добавить, удалить, сжать и расширить разделы диска вместе с файловыми системами, расположенными на них.

# apt-get install parted

Данная утилита требуется для настройки устройств хранения информации по инструкции «CentOS 7: Как добавить новый диск».

9.8.3. Установка Crony.

Chrony — это гибкая реализация протокола сетевого времени — Network Time Protocol (NTP). Используется для синхронизации системных часов с различных NTP-серверов, эталонных часов или с помощью ручного ввода.

# apt-get install chrony

9.8.4. Установка Net-tools.

NetTOOLS — набор сетевых онлайн инструментов и утилит для оптимизации и диагностики сетевых ресурсов, круглосуточный мониторинг сетевых ресурсов, сетевые онлайн утилиты для работы в сети, сетевые утилиты, онлайн пинг, whois, nslookup, ping, traceroute.

# apt-get install net-tools

10. Про бэкапы в Proxmox VE.

Штатные инструменты Proxmox позволяют не только выполнять резервное копирование данных, но и создавать наборы предварительно настроенных образов операционных систем для быстрого развертывания. Это не только помогает при необходимости создать новый сервер для любого сервиса за несколько секунд, но также и уменьшает время простоя до минимального.

10.1. Алгоритмы резервного копирования.

Начнем с того, что Proxmox имеет неплохой штатный инструментарий для создания резервных копий виртуальных машин. Он позволяет легко сохранить все данные виртуальной машины и поддерживает два механизма сжатия, а также три метода создания этих копий.

Разберем вначале механизмы сжатия:

10.2. Режимы архивирования.

Proxmox предлагает на выбор системному администратору три метода резервного копирования. С помощью них можно решить требуемую задачу, определив приоритет между необходимостью простоя и надежностью сделанной резервной копии:

11. Выполнение процедуры резервирования.

Для создания резервной копии:

1. Переходим на нужную виртуальную машину.

2. Выбираем пункт Резервирование.

3. Нажимаем кнопку Резервировать сейчас. Откроется окно, в котором можно будет выбрать параметры будущей резервной копии.

4. В качестве хранилища указываем то, которое мы подключали выше по тексту инструкции.

5. После выбора параметров нажимаем кнопку Резервирование и ждем, пока резервная копия будет создана. Об этом будет говорить надпись TASK OK.

Теперь созданные архивы с резервными копиями виртуальных машин станут доступны для скачивания с сервера. Самым простым и банальным способом копирования является SFTP. Для этого воспользуйтесь популярным кроссплатформенным FTP-клиентом FileZilla, который умеет работать по SFTP-протоколу.

Резервные копии рекомендуется сразу скачивать с сервера и сохранять в надежном месте, например, в нашем облачном хранилище. Если распаковать файл с разрешением vma, одноименной утилитой, идущей в комплекте с Proxmox, то внутри будут файлы с расширениями raw, conf и fw.

В этих файлах содержится следующее:

12. Восстановление из резервной копии.

Рассмотрим ситуацию, когда виртуальную машину случайно удалили и требуется ее экстренное восстановление из резервной копии:

1. Открываем хранилище, на котором лежит резервная копия.

2. Переходим на вкладку Содержимое.

3. Выбираем нужную копию и нажимаем кнопку Восстановление.

4. Указываем целевое хранилище и ID, который будет присвоен виртуальной машине, после завершения процесса.

5. Нажимаем кнопку Восстановление. Как только восстановление завершится, виртуальная машина появится в списке доступных.

13. Клонирование виртуальной машины.

Для примера, предположим, что в компании требуется внести изменения в какой-либо критичный сервис. Такое изменение реализуется через внесение множества правок в конфигурационные файлы. Результат при этом непредсказуем и любая ошибка способна вызвать сбой сервиса. Чтобы подобный эксперимент не затронул работающий сервер, рекомендуется выполнить клонирование виртуальной машины.

Механизм клонирования создаст точную копию виртуального сервера, с которой допустимо проводить любые изменения, при этом не затрагивая работу основного сервиса. Затем, если изменения будут успешно применены, новая виртуальная машина запускается в работу, а старая выключается. В этом процессе есть особенность, о которой всегда следует помнить. На клонированной виртуальной машине IP-адрес будет точно таким же, как и у исходной виртуальной машины, то есть при ее запуске возникнет конфликт адресов.

Расскажем, как избежать такой ситуации. Непосредственно перед выполнением клонирования, следует внести изменения в конфигурацию сети. Для этого необходимо временно изменить IP-адрес, но не перезапускать сетевой сервис. После выполнения клонирования на основной виртуальной машине следует вернуть настройки обратно, а на клонированной виртуально машине задать любой другой IP-адрес. Тем самым мы получим две копии одного и того же сервера на разных адресах. Это позволит быстро ввести новый сервис в работу.

Если этим сервисом является веб-сервер, то достаточно только изменить А-запись у вашего DNS-провайдера, после чего запросы клиентов по этому доменному имени будут направляться уже на адрес клонированной виртуальной машины.

Клонирование виртуальной машины в Proxmox является очень простой задачей. Для ее выполнения необходимо выполнить следующие действия:

1. Перейти на нужную нам виртуальную машину.

2. Выбрать из меню More пункт Clone.

3. В открывшемся окне заполнить параметр Имя.

4. Выполнить клонирование нажатием кнопки Clone.

Этот инструмент позволяет сделать копию виртуальной машины не только на локальном сервере. Если несколько серверов виртуализации объединить в кластер, то с помощью этого инструмента можно сразу переместить созданную копию на нужный физический сервер. Полезной функцией является выбор дискового хранилища (параметр Target Storage), что очень удобно при перемещении виртуальной машины с одного физического носителя на другой.

14. Работа с образами дисков.

В комплекте c Proxmox есть очень удобная утилита, под названием qemu-img. Одной из ее функций является конвертирование образов виртуальных дисков.

14.1. Файл справки.

Чтобы воспользоваться им, достаточно открыть консоль гипервизора и выполнить команду в формате:

Внимание! Иногда процесс конвертации может и не стартовать, потому что файлы виртуального жесткого диска могут быть старой версии или чего-то может не хватать. Выход из этой ситуации — это правильно подбирать ключи и команды конвертирования под частные случаи.

14.2. Конвертирование.

В приведенном примере, vmdk-образ виртуального накопителя VMware под названием test будет преобразован в формат qcow2.

Это очень полезная команда, когда требуется исправить ошибку при изначальном выборе формата.

14.3. Создание образа.

Благодаря этой же команде можно принудительно создать нужный образ, используя аргумент create:

Такая команда создаст образ test в формате RAW, размером 40 Гб. Теперь он годится для подключения к любой из виртуальных машин.

15. Изменение размера виртуального диска.

И в заключение покажем как увеличить размер образа диска, если по каким-то причинам места на нем перестало хватать. Для этого воспользуемся аргументом resize:

Теперь наш образ стал размером 80 Гб. Посмотреть подробную информацию об образе можно с помощью аргумента info:

# qemu-img info test.raw

Не стоит забывать, что само расширение образа не увеличит размер раздела автоматически — просто добавит доступное свободное пространство. Для увеличения раздела воспользуйтесь командой:

где /dev/sda1 — нужный раздел.

16. Автоматизация создания резервных копий.

Использование ручного способа создания резервных копий — задача весьма трудоемкая и занимает много времени. Поэтому Proxmox VE содержит в себе средство для автоматического резервного копирования по расписанию.

Рассмотрим, как это сделать:

1. Используя веб-интерфейс гипервизора, открываем пункт Datacenter.

2. Выбираем пункт Резервирование.

3. Нажимаем кнопку Добавить.

4. Задаем параметры для планировщика.

5. Отмечаем галочкой пункт Включить.

6. Сохраняем изменения, используя кнопку Создать.

Теперь планировщик будет автоматически запускать программу резервного копирования в точно указанное время, исходя из заданного расписания.

17. Управление гипервизором консольными командами.

17.1. Просмотр списка виртуальных машин.

Посмотрим список всех созданных виртуальных машин на гипервизоре:

17.2. Управление виртуальными машинами.

Теперь можно управлять состоянием виртуальных машин c помощью их VMID в системе Proxmox:

# qm start — запуск;

# qm status — посмотреть состояние;

# qm shutdown — штатное выключение через ACPI;

# qm reset — перезагрузка;

# qm stop — принудительная остановка;

# qm suspend — приостановка с возможностью возобновления работы;

# qm resume — возобновление работы;

# qm destroy — удаление виртуальной машины (вместе с образами дисков);

Ответ:

17.3. Просмотр конфигурации виртуальных машин.

17.4. Просмотр файла справки HELP в консоли.

Для просмотра всех возможных команд и получения файла справки HELP ведите одиночную команду:

Ответ:

Таким же образом можно запросить более развернутый ответ по конкретной команде.

Например, запросим ответ на команду stop :

Ответ:

18. Установка Proxmox VE на Ubuntu и CentOS.

Возможно, кому-то захочется установить Proxmox VE именно на Ubuntu или CentOS. К сожалению, разработчики остановились на Debian. Возможно, есть неофициальные обходные пути установки Proxmox VE на другие дистрибутивы GNU/Linux, однако такой путь не является приемлемым для продуктивной среды.

19. Оригиналы источников информации.

Заметки на полях:

1. Где хранятся образы виртуальных дисков виртуальных машин?

Стандартное расположение, если не указано другое:

2. Где хранятся образы виртуальных дисков ISO?

Стандартное расположение, если не указано другое:

3. Где хранятся логи Proxmox VE?

Логи хранятся по пути: