spark python 3 обучение

Руководство по PySpark для начинающих

PySpark — это API Apache Spark, который представляет собой систему с открытым исходным кодом, применяемую для распределенной обработки больших данных. Изначально она была разработана на языке программирования Scala в Калифорнийском университете Беркли.

Spark предоставляет API для Scala, Java, Python и R. Система поддерживает повторное использование кода между рабочими задачами, пакетную обработку данных, интерактивные запросы, аналитику в реальном времени, машинное обучение и вычисления на графах. Она использует кэширование в памяти и оптимизированное выполнение запросов к данным любого размера.

У нее нет одной собственной файловой системы, такой как Hadoop Distributed File System (HDFS), вместо этого Spark поддерживает множество популярных файловых систем, таких как HDFS, HBase, Cassandra, Amazon S3, Amazon Redshift, Couchbase и т. д.

Преимущества использования Apache Spark:

Настройка среды в Google Colab

Чтобы запустить pyspark на локальной машине, нам понадобится Java и еще некоторое программное обеспечение. Поэтому вместо сложной процедуры установки мы используем Google Colaboratory, который идеально удовлетворяет наши требования к оборудованию, и также поставляется с широким набором библиотек для анализа данных и машинного обучения. Таким образом, нам остается только установить пакеты pyspark и Py4J. Py4J позволяет программам Python, работающим в интерпретаторе Python, динамически обращаться к объектам Java из виртуальной машины Java.

Итоговый ноутбук можно скачать в репозитории: https://gitlab.com/PythonRu/notebooks/-/blob/master/pyspark_beginner.ipynb

Команда для установки вышеуказанных пакетов:

Spark Session

SparkSession стал точкой входа в PySpark, начиная с версии 2.0: ранее для этого использовался SparkContext. SparkSession — это способ инициализации базовой функциональности PySpark для программного создания PySpark RDD, DataFrame и Dataset. Его можно использовать вместо SQLContext, HiveContext и других контекстов, определенных до 2.0.

Создание SparkSession

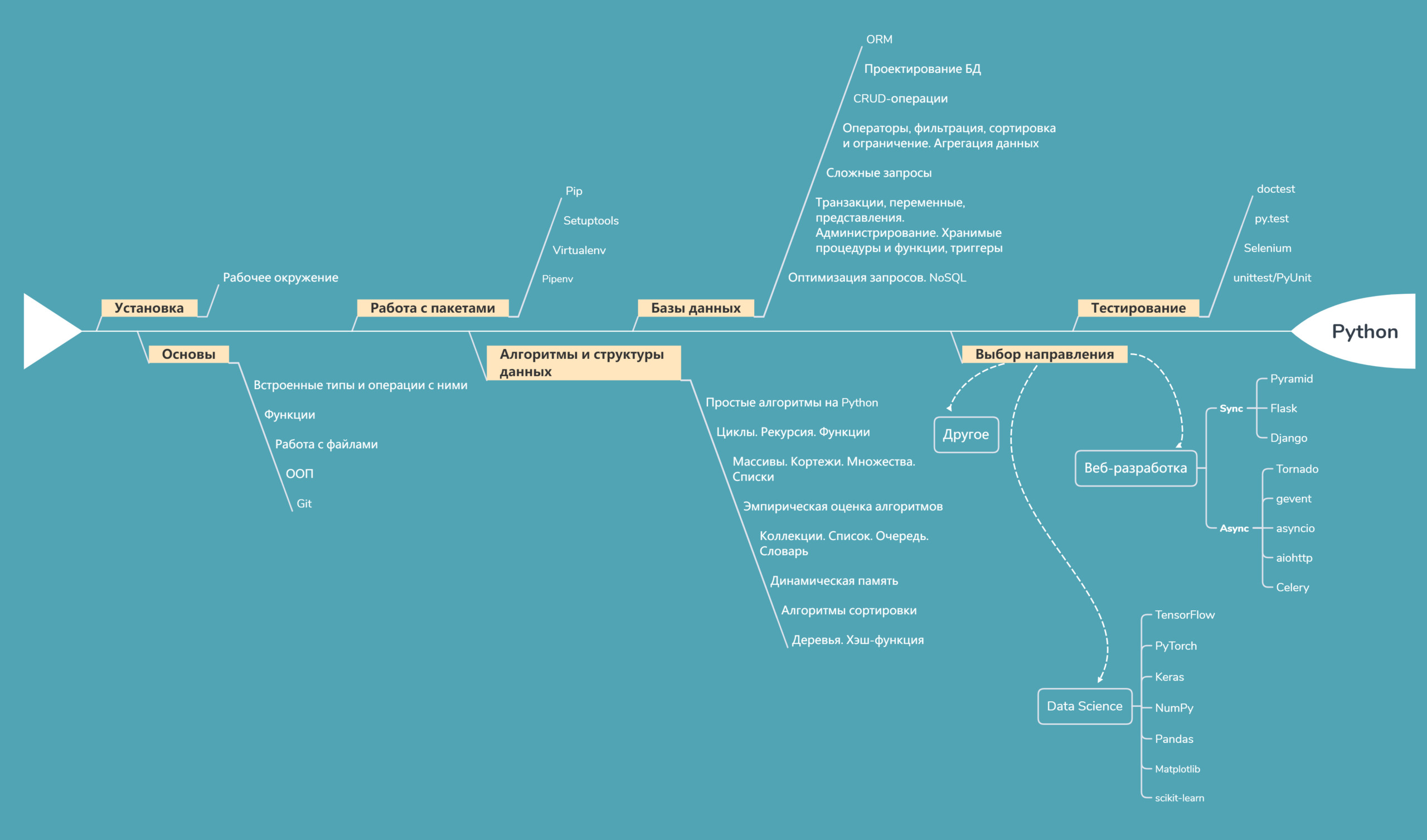

Программирование на Python с нуля: дорожная карта разработчика

Авторизуйтесь

Программирование на Python с нуля: дорожная карта разработчика

Программирование на Python с нуля: легко или не очень? По факту, изучение Python почти ничем не отличается от изучения любого другого языка. Всё стандартно: установка, настройка рабочего окружения, базы данных, переменные, функции и первый «Hello World». Но дальше — круче, ведь в ход идёт разделение на сферы применения, синхронное и асинхронное программирование, тестирование и сопутствующие инструменты, часто индивидуальные для каждого языка.

Чтобы окончательно не запутаться, нужно всё структурировать. Именно поэтому мы совместно с Факультетом Python-разработки GeekUniversity составили дорожную карту, которая поможет в изучении Python с нуля.

Что нужно знать Python-разработчику?

Пласт базовых знаний и навыков включает в себя:

Разумеется, недостаточно реализовать вывод «Hello World», чтобы разобраться в языке программирования Python, но для более глубокого понимания сперва стоит определиться с направлением, в котором вы хотите работать. Исходя из этого, подбираются дополнительные инструменты для изучения.

Веб-разработка

Здесь особенно популярны такие Python-фреймворки, как Django и Flask: с их помощью можно быстро создать логику бэкенда. Для начала работы хватит и одного, но не помешает знать несколько, понимать, в каких случаях они используются, где предпочесть Django, а с какой задачей лучше справится Flask, Tornado или Pyramid.

Для построения веб-приложений также пригодится знание протоколов, HTML, CSS и JavaScript.

Django 2 в примерах

Django — популярный Python-фреймворк для написания веб-приложений. Многие начинающие разработчики выбирают его из-за относительной простоты и лёгкости в развитии. Однако это совсем не означает, что фреймворк не справится с профессиональными высоконагруженными системами.

В рамках этого курса вы поэтапно изучите процесс создания полноценного приложения на Django. Помимо работы с основными компонентами фреймворка, вы научитесь грамотно подбирать и интегрировать сторонние библиотеки. Эта книга лишена непонятных, скучных и абстрактных задач — в ней только то, что вам действительно пригодится на практике.

В процессе обучения вы получите не только знания о принципах работы Django, но и опыт в разработке веб-приложений, которые в перспективе планируется расширять дополнительными инструментами.

Полезно как для начинающих разработчиков, так и для специалистов.

Разработка веб-приложений с использованием Flask на языке Python

В данном издании вы изучите Python-фреймворк Flask. Он относится к категории микрофреймворков — простых каркасов для веб-приложений, обладающих только базовыми возможностями. Благодаря пошаговым примерам вы сможете создать полноценное веб-приложение для социального блогинга.

Благодаря этой книге вы освоите возможности фреймворка и ознакомитесь с различными прикладными технологиями, такими как взаимодействие веб-служб и миграции баз данных.

На фоне других Flask выделяется полной свободой в разработке. Если вы уже имеете опыт работы с Python, то изучение этого фреймворка не составит никакого труда.

Data Science

Основы программирования на Python в разрезе Data Science следует продолжить изучением таких библиотек и фреймворков:

Для погружения в Machine Learning на Python, обучение стоит начать с основных разделов, а именно:

Книги по теме

Крупномасштабное машинное обучение вместе с Python

Хороша та книга, которая учит использовать мощные алгоритмы в машинном обучении без интеграции затратных решений или массивных вычислительных систем. Данное издание как раз об этом.

Благодаря этой книге вы познакомитесь с Scikit-Learn и научитесь работать с нейросетями с помощью библиотек Theano, TensorFlow и H2O. В процессе вы рассмотрите классификационные и регрессионные деревья, а также способы обучения нейросетей без учителя.

В книге рассмотрены принципы машинного обучения в модели MapReduce на Hadoop и Spark.

Python для сложных задач. Наука о данных и машинное обучение

В данной книге описаны самые различные вычислительные методы и статистические алгоритмы. Без их использования невозможна какая-либо интенсивная обработка данных и проведение исследований.

Данное пособие будет полезно тем читателям, которые уже имеют какой-либо опыт в программировании и хотят научиться правильно использовать Python в Data Science. Например, как преобразовывать определённый формат данных в файл скрипта? Как сформировать и отфильтровать эти данные и работать с ними? Как благодаря полученной информации проанализировать ситуацию, составить статистическую модель и организовать машинное обучение.

Другие направления

Конечно, можно изучать Python для программирования игр, написания десктопных и мобильных приложений, но несмотря на наличие соответствующих для этого инструментов, язык наиболее востребован именно в Data Science и бэкенд-разработке.

Основные инструменты Python-разработчика

Изучение Питона не может быть полноценным без набора полезных инструментов под рукой. Мы собрали небольшой список и разделили его на категории.

Базовые

Документация

Тестирование

Прочие

Дополнительные материалы

Чтобы обучение языку Python с нуля было максимально эффективным, следует запастись полезными ресурсами.

Книги

Изучаем Python. Программирование игр, визуализация данных, веб-приложения

Эта книга представляет из себя курс, который за короткое время даст вам все необходимые базовые знания о геймдеве, разработке веб-приложений и визуализации данных. Сначала вы узнаете об основных принципах программирования: циклы, ветвления, списки, классы, словари. Вы научитесь грамотно разрабатывать программы и проводить тестирование кода.

Далее вы сразу сможете применить полученные знания в 3 крупных проектах: шутер с динамической сложностью, обработка и визуализация большого объёма данных, и веб-приложение на Django, гарантирующее пользователям конфиденциальность.

Изучаем программирование на Python

Возможно, вам уже надоели однотипные и непонятные руководства по программированию. Если да, то рекомендуем к прочтению эту книгу. Она рассчитана на начинающих разработчиков.

В процессе вы создадите полноценное веб-приложение и научитесь управлять базами данных, отслеживать и обрабатывать исключения, а также использовать контекстные менеджеры. Вы научитесь пользоваться декораторами и генераторами.

Python 3 и PyQt 5. Разработка приложений

В этой книге рассказывается о Python 3: функции, типы данных, операторы и принципы ООП. Также из неё вы узнаете о прикладных возможностях языка: регулярные выражения, популярные инструменты стандартной библиотеки и работа с файлами. Тут вы ознакомитесь с системой SQLite, узнаете о способах доступа к базам данных и методах получения информации из них.

Много моментов посвящено модулю PyQt 5, который позволяет без лишнего труда разрабатывать приложения с графической оболочкой на Python.

Также в книге рассказывается обо всех необходимых интерфейсных компонентах: кнопки, панели, меню, текстовые поля и многое другое. Тут вы узнаете, как грамотно работать с многопоточностью и обрабатывать события.

Курсы Python

Отличным подспорьем для изучения Python станут видеолекции:

Но курсы программирования на Python этим не ограничиваются. Освоить базу из представленной дорожной карты можно в онлайн-университете GeekBrains, где помимо теории есть возможность прокачать и практические навыки: создать интернет-магазин, сетевой чат, поработать в команде и получить фидбек от опытных разработчиков.

Подкасты

Что дальше?

Не останавливайтесь на достигнутом, ведь изучение Python с нуля — задача непростая, несмотря на всю лёгкость языка. Как только знания станут уверенными, переходите к использованию теории на практике. В этом поможет игра Python Challenge, где нужно решать задачки с помощью написания небольших программ: с каждым пройденным этапом будет увеличиваться сложность. Также вы можете поучаствовать в работе над любым open source проектом.

Изучайте теорию, закрепляйте практикой и переходите к реальным задачам.

🐍 Где изучать Python в 2021 году: 78 ресурсов для начинающих

Ресурсы отобраны по четырем направлениям:

Курсы по Питону для начинающих

Основы Python 3 (Udemy, 19 лекций) – установите Python на Windows и Mac OS, напишите Hello, World!, узнаете какие бывают типы чисел и что такое строка и ее свойства.

Python – практика для начинающих (Udemy, 8 лекций) – в этом курсе узнаете: что такое ООП, функции, циклы и условные операторы и остальные базовые понятия.

Программирование на Python (Stepik, 28 уроков) – познакомитесь с базовыми понятиями языка Python: как установить Python на компьютер, операции с числами, типы данных и условные операторы if, else, elif.

Python – практические задачи (Stepik, 21 урок) – дают основы Python: ввод данных, условия, циклы, функции и словари.

«Поколение Python»: курс для начинающих (Stepik, 61 урок) – модули курса включают в себя: ввод-вывод данных, типы данных, условные операторы, циклы for и while и работу над мини-проектом. Курс стал победителем Stepik Awards 2020 в номинации «Лучший бесплатный онлайн-курс, размещенный на платформе Stepik».

Основы программирования на языке Python в примерах и задачах (Stepik, 19 уроков) – курс ориентирован на практику; даются минимальные теоретические аспекты программирования для решения задач. В научно-популярной форме объясняется суть каждой задачи.

Python: основы и применение (Stepik, 19 уроков) – курс для тех, кто уже знаком с базой. Научитесь писать функции, работать с модулями, файловой системой, лямбда-функциями и примените полученные знания для анализа текста.

Основы программирования на Python (Coursera, 60 видео) – познакомитесь с ООП, процедурным и функциональным программированием и, конечно, с базовыми понятиями.

Python для начинающих (YouTube, 17 уроков) – рассказывают про Питон, начиная с типов данных, условных операторов, заканчивая множествами и ООП. В конце курса напишите Telegram-бота для приема платежей.

Учим Python за 1 час! (YouTube, 4 млн просмотров) – спидран по Питону.

Python-джедай (YouTube, 20 уроков) – продолжение курса Учим Python за 1 час! на 5.5 часов. Пройдете путь от азов до функционального программирования.

Уроки Python для начинающих (YouTube, 25 уроков) – Гоша Дударь рассказывает и показывает, как программировать на Python.

Python для Начинающих (YouTube, 36 уроков) – Питон с нуля, плюс два проекта на Django.

Дополнительные курсы

Основы Git (Stepik, 25 уроков) – курс по Git в формате практикума.

Основы Linux (Stepik, 34 урока) – курс основан на книге «Фундаментальные основы Linux» и рекомендован для начинающих сисадминов.

Введение в Linux (Stepik, 23 урока) – познакомитесь с ОС Linux и основами ее использования.

Интерактивные курсы и онлайн-тренажеры

Адаптивный тренажер Python (Stepik, 53 урока) – десятки задач разных уровней сложности.

Питонтьютор (11 занятий) – интерактивный учебник по основам программирования на Питоне. Больше сотни интересных задач.

Code Basics (69 уроков) – всеобъемлющий курс по Питону для начинающих.

letpy (16 уроков) – дают базовые знания, а если нужно больше – на сайте есть подробный справочник по методам, операторам и т. д.

Телеграм-каналы

Библиотека питониста – полезные материалы по всему, что может быть полезно питонисту.

Pythonist.ru – разбор вопросов с собеседований, книги, тесты и задачи на логику.

Python задачки – задачки по питону: алгоритмы, регулярные выражения, задачи для джунов.

Python Books – книги по программированию в формате PDF.

Python in Depth – рассказывают об основах программирования и лучших практиках.

Python Quiz – протестируйте ваши знания Питона.

Python (11 тыс. участников) – питоний чат.

SPb Python (1.5 тыс. участников) – чат питонщиков из СПб.

Python (2 тыс. подписчиков) – еще один чат.

PythonNoobs – канал для новичков.

Машинное обучение

Введение в Data Science и машинное обучение (Stepik, 30 уроков) – подробно разбирают теорию и учат работать с библиотеками pandas и numpy.

Машинное обучение (Stepik, 71 урок) – узнаете как обрабатывать данные и поймете как строить модели машинного обучения.

Быстрый старт в искусственный интеллект (Stepik, 23 урока) – разбирают четыре модуля: машинное обучение, компьютерное зрение, обработка естественного языка, математические идеи в анализе данных и искусственном интеллекте.

Нейронные сети (Stepik, 24 урока) – объясняют алгоритмы, лежащие в основе нейронных сетей и их практическое применение.

Нейронные сети и компьютерное зрение (Stepik, 37 уроков ) – сделаете первые шаги в области компьютерного зрения с методами машинного обучения. Этот курс получил премию «Stepik Awards 2019».

Deep Learning: базовый поток (Stepik, 39 уроков) – дают базу по высшей математике и Питону.

Аналитика с pandas (Stepik, 10 уроков) – аналитика с помощью библиотеки pandas в Python

Специализация «Машинное обучение и анализ данных» (Coursera, 6 курсов) – познакомитесь с математическим анализом, научитесь размечать и строить выводы по данным и получите другие мастхэв математические знания.

Введение в машинное обучение (Coursera, 31 видео) – изучите основные типы задач, решаемых с помощью машинного обучения: классификация, регрессия и кластеризация.

Курс OpenDataScience и Mail.ru Group по машинному обучению (YouTube, 10 лекций) – рассказывают о классификации, регрессиях, временных рядах, градиентном бустинге и так далее.

Машинное обучение от ВШЭ (YouTube, 61 видео) – курс по машинному обучению для бакалавров НИУ ВШЭ.

Машинное обучение (YouTube, 22 видео) – курс от школы анализа данных Яндекса.

Телеграм-каналы

Библиотека data scientist’а – полезные материалы по всему, что может быть интересно дата сайентисту.

gonzo-обзоры ML статей – обзоры статей по машинному обучению.

Machine Learning World – последние новости из AI и ML.

Hey Machine Learning – новости, кейсы, разборы интересных проектов из мира ИИ.

NeuroHive – Нейронные сети – канал про нейронные сети и новейшие методы в машинном обучении.

addmeto – новости из мира искусственного интеллекта и машинного обучения.

Data Science и все такое – простым языком об анализе данных, машинном обучении и обо всем таком.

OpenDataScience RU – анонсы мероприятий по Data Science.

Machinelearning – актуальная информация из мира ML, нейронных сетей.

Data Science Chat (4.5 тыс. участников) – чат о Data Science.

Нейронные сети (AI Community) (2.7 тыс. участников.) – чат про нейронные сети.

AI / Big Data / Machine Learning (5 тыс. участников) – чат про Data Science, Big Data, AI, ML.

Веб-разработка

Django (YouTube, 52 видео) – полный курс по фреймворку Django. Даже капчу поставите.

Создание сайта на Django (YouTube, 12 видео) – Гоша Дударь рассказывает как запилить свой первый сайт. Также есть курс в коротком полуторачасовом формате.

Уроки Django | Django Docker Nginx Gunicorn (YouTube, 30 мин.) – узнаете как завернуть Джанго-проект в докер и настроить обработку запросов на nginx и gunicorn.

Бекенд на Django (YouTube, 10 уроков) – хорошая подача материала.

Тестирование в Django (YouTube, 148 лайков и 2 дизлайка) – протестируете django-проект и познакомитесь с модулем mock.

Изучение Flask (YouTube, 3 видео) – создадите веб-блог.

Flask: делаем простое веб приложение на Python (YouTube, 15 мин.) – сделаете простое веб-приложение с формами ввода.

Телеграм-каналы

Python/ django – публикуют ссылки на обучающие статьи.

Django [ru] (4.2 тыс. участников)– русскоязычный чат по Джанго

Django (800 участников) – чат по Джанго.

Python Flask (1.5 тыс. участников) – чат по Flask.

Тестирование

Автоматизация тестирования с помощью Selenium и Python (Stepik, 26 уроков) – научитесь писать автотесты, использовать тестовые фреймворки и работать с git и GitHub.

Unit тесты в Python. Тестирование кода (YouTube, 354 лайка и 8 дизлайков) – протестируете код вдоль и поперек.

Pytest: введение в автотесты (YouTube) – расскажут как работать с библиотекой pytest.

Эффективное тестирование с pytest (YouTube) – научитесь запускать тесты c помощью pytest.

Тесты в Python: легкий старт (YouTube) – пошаговая инструкция на примерах: чем тестировать, что тестировать, как тестировать.

Телеграм-каналы

Библиотека тестировщика (2 тыс. участников) – полезные материалы по всему, что может быть интересно тестировщику.

QA_PRO (3.5 тыс. участников) – информация для профессиональных тестировщиков и QA инженеров.

Тестирование и жизнь (1 тыс. участников) – канал про тестирование, работу, образование и все около того.

Spark python 3 обучение

Говоря про обучение Apache Spark для разработчиков, сегодня мы рассмотрим, как быстро конвертировать Python-скрипты в задания PySpark и какие конфигурационные параметры при этом нужно настроить, чтобы эффективно использовать все возможности распределенных вычислений над большими данными (Big Data). Читайте далее, чем отличаются датафреймы в Pandas и Apache Spark, для чего нужны Arrow и Koalas, а также как оптимально превратить локальный датасет в RDD.

5 шагов от Python-скриптов к заданиям PySpark

Прежде всего, напомним, что язык программирования Python ориентирован на локальную работу с данными в пределах одного компьютера, тогда как Apache Spark – это фреймворк распределенных вычислений, где данные распределены по нескольким узлам кластера. Поэтому, несмотря на наличие API-интерфейса Python в Spark, называемого PySpark, чтобы использовать всю мощь распределенной среды, Python-код не просто конвертируется в задания PySpark, а требует последующей настройки. При этом необходимо поработать как с датасетом, приведя в соответствие структуры данных, так и с программной логикой, выполнив следующие действия [1]:

При работе с Apache Arrow, следует установить конфигурационный параметр Spark spark.sql.execution.arrow.pyspark.enabled в значение True. Ниже показан пример, как это сделать на PySpark:

import numpy as np

import pandas as pd

# Enable Arrow-based spark configuration

# Generate a pandas DataFrame

# Create a Spark DataFrame from a pandas DataFrame using Arrow

# Convert the Spark DataFrame back to a pandas DataFrame using Arrow

UDF в PySpark можно определить двумя способами:

В любом случае, UDF PySpark принимает столбцы и применяет логику построчно для создания нового столбца. Например, следующий код показывает, как определить UDF-функцию возведения целого числа в квадрат:

from pyspark.sql.functions import col, udf

from pyspark.sql.types import IntegerType

square_udf = udf(lambda x: squared(x), IntegerType())

df = spark.createDataFrame([(4),(8)], [“numbers”])

#Load dataset as RDD

path=”file path with file name”

#Load dataset as DataFrame

Полученное таким образом приложение PySpark нуждается в дополнительной настройке параметров. Это стоит сделать, чтобы более эффективно работать в кластере Apache Spark, оптимально используя все ресурсы распределенной среды. Частично эту проблему решает развертывание Spark-заданий решает их развертывание в кластере Kubernetes, о чем мы рассказываем здесь. А как самостоятельно оптимизировать переход на распределенный режим с локального Python-приложения, мы рассмотрим далее.

Что настроить в приложении Apache Spark: 5 главных факторов

Итак, поскольку приложение PySpark выполняется в распределенной среде кластера Apache Spark, при настройке Spark-заданий перед их запуском стоит учитывать следующие аспекты [1]:

Широковещательный набор данных означает, что данные будут доступны для всех исполнителей, что снижает перетасовку данных и уменьшает накладные расходы на передачу данных по сети. Использовать broadcast-переменные целесообразно в следующих случаях:

По умолчанию параметр spark.sql.autoBroadcastJoinThreshold равен 10 МБ, что означает максимальный размер в байтах для таблицы, которая будет транслироваться всем рабочим узлам при выполнении соединения. Изменить это значение можно до того размера, который требуется установить для трансляции большого датасета другим узлам кластера Spark [2].

Переключиться на использование Kryo можно, инициализировав задание с помощью объекта SparkConf, например, conf.set(“spark.serializer”, “org.apache.spark.serializer.KryoSerializer”). Также можно задать сериализатор в команде spark-submit: – conf spark.serializer = org.apache.spark.serializer.KryoSerializer.

С сериализацией и десериализацией также связан фактор формата данных. В частности, Avro и Parquet предпочтительнее для файлов с большими данными, чем текстовые форматы, CSV и JSON.

Завтра мы продолжим разбираться с методами повышения производительности Spark-приложений и рассмотрим особенности кэширования SQL-запросов в этом Big Data фреймворке. А освоить все особенности администрирования и разработки Apache Spark для аналитики больших данных вы сможете на специализированных курсах в нашем лицензированном учебном центре обучения и повышения квалификации для разработчиков, менеджеров, архитекторов, инженеров, администраторов, Data Scientist’ов и аналитиков Big Data в Москве: